一文说尽大模型技术之一:LLM的架构

作者:幂简科技 · 2024-07-22 · 阅读时间:4分钟

原文较长,细度之后可以分为三方方面分别深入了解,让我们对大语言模型起到抛砖引玉的作用,感谢原博主的整理:

- 一文说尽大语言模型技术之一:LLM的架构

- 一文说尽大语言模型技术之二:LLM的分布式预训练

- 一文说尽大语言模型技术之三:LLM的参数高效微

大家好,我是花哥,本文分为三个章节,深入浅出地解读大模型的技术,具体如下三个部分:

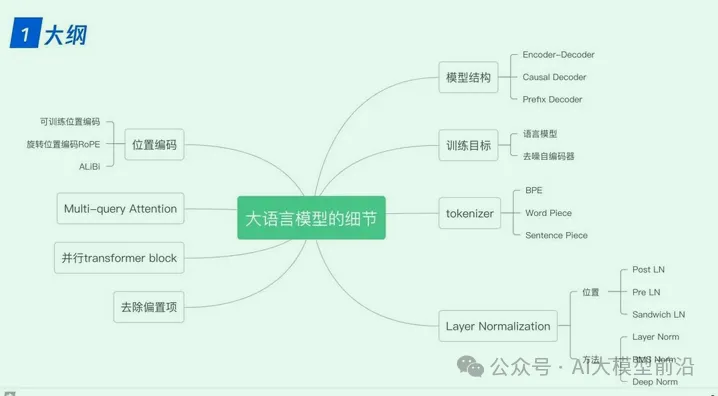

1、GPT、LLaMA、ChatGLM、Falcon等大语言模型的技术细节比较

在深入研究LLaMA、ChatGLM和Falcon等大语言模型时,我们不难发现它们在技术实现上有着诸多共通之处与独特差异。例如,这些模型在tokenizer(分词器)的选择上,可能会根据模型的特性和应用场景来定制;位置编码(Positional Encoding)的实现方式也各具特色,对模型性能的影响不容忽视。此外,Layer Normalization(层归一化)和激活函数(Activation Function)的选择与运用,都直接影响到模型的训练速度和准确性。

2、大语言模型的分布式训练技术概览

2、大语言模型的分布式训练技术概览

3、大语言模型的参数高效微调技术探索

1. 大语言模型的细节

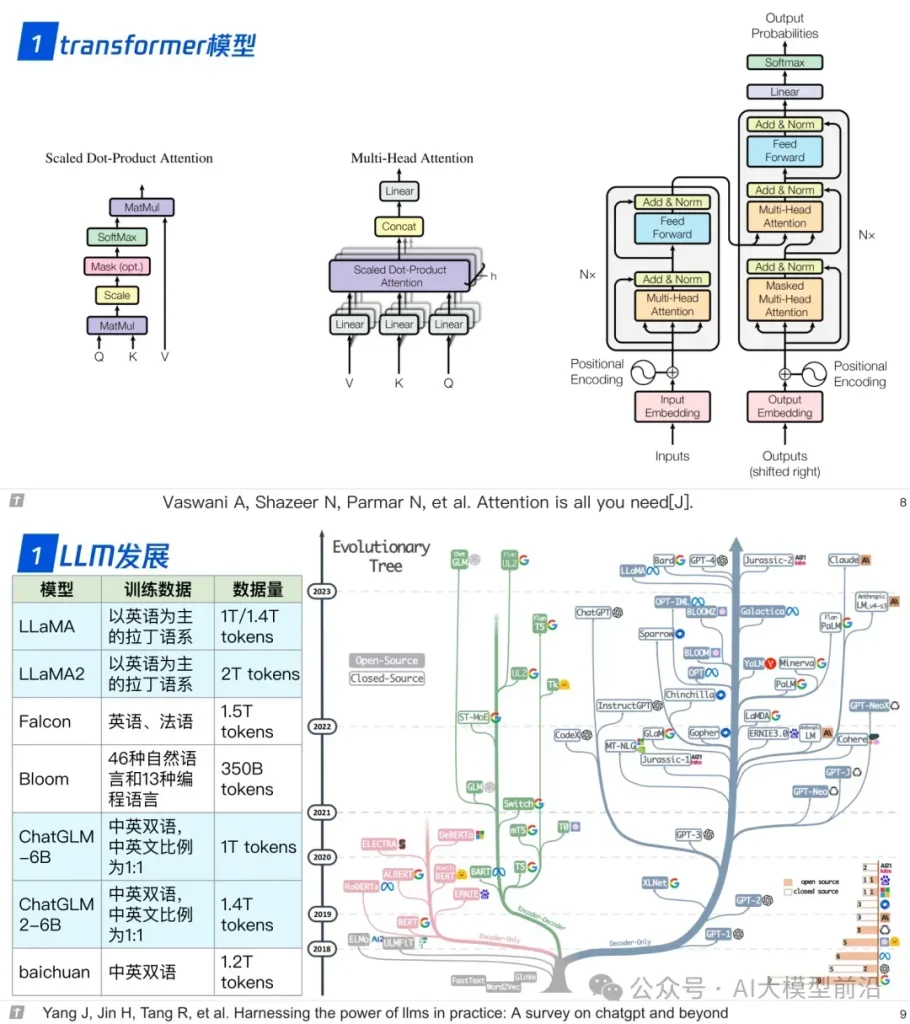

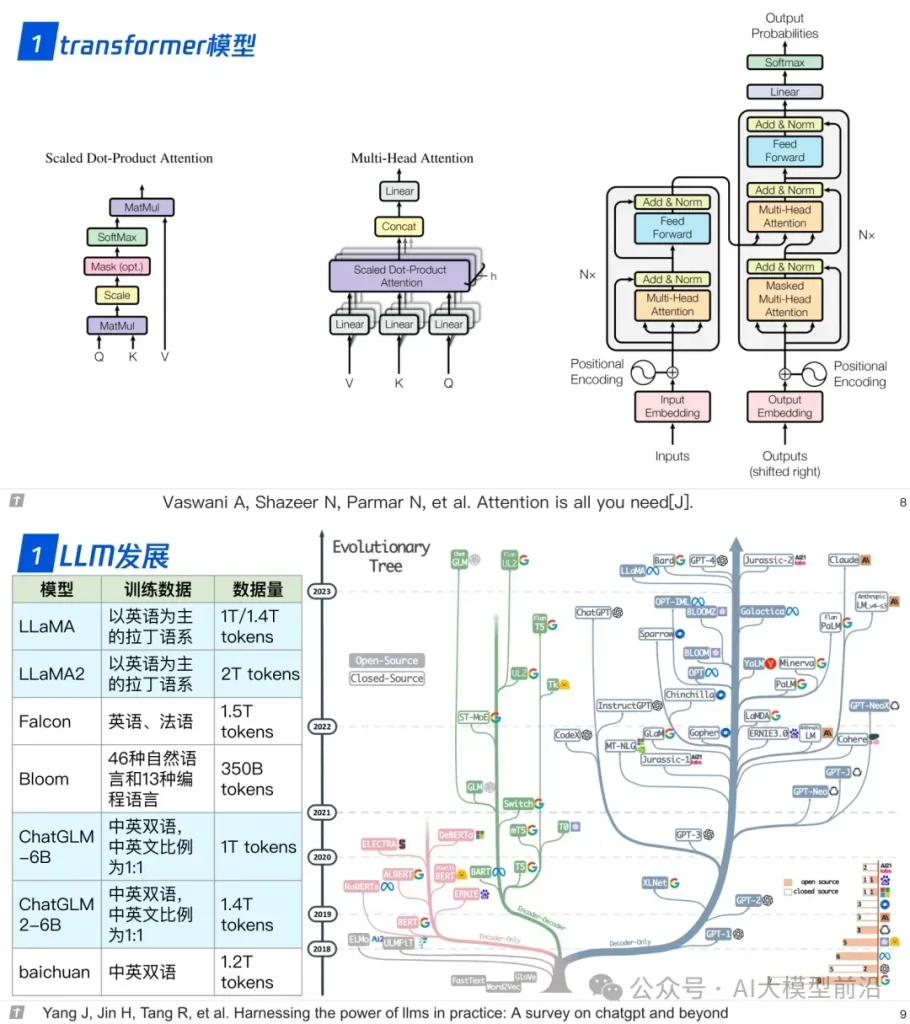

1.0 transformer 与 LLM

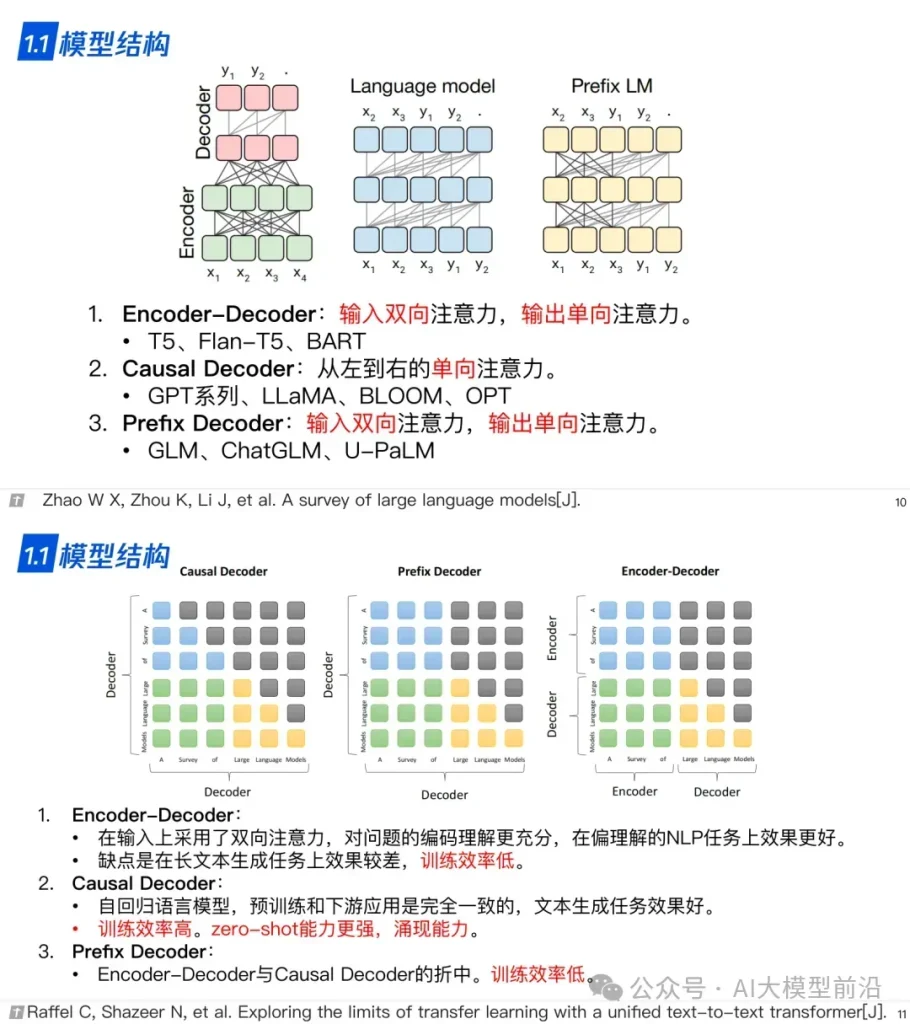

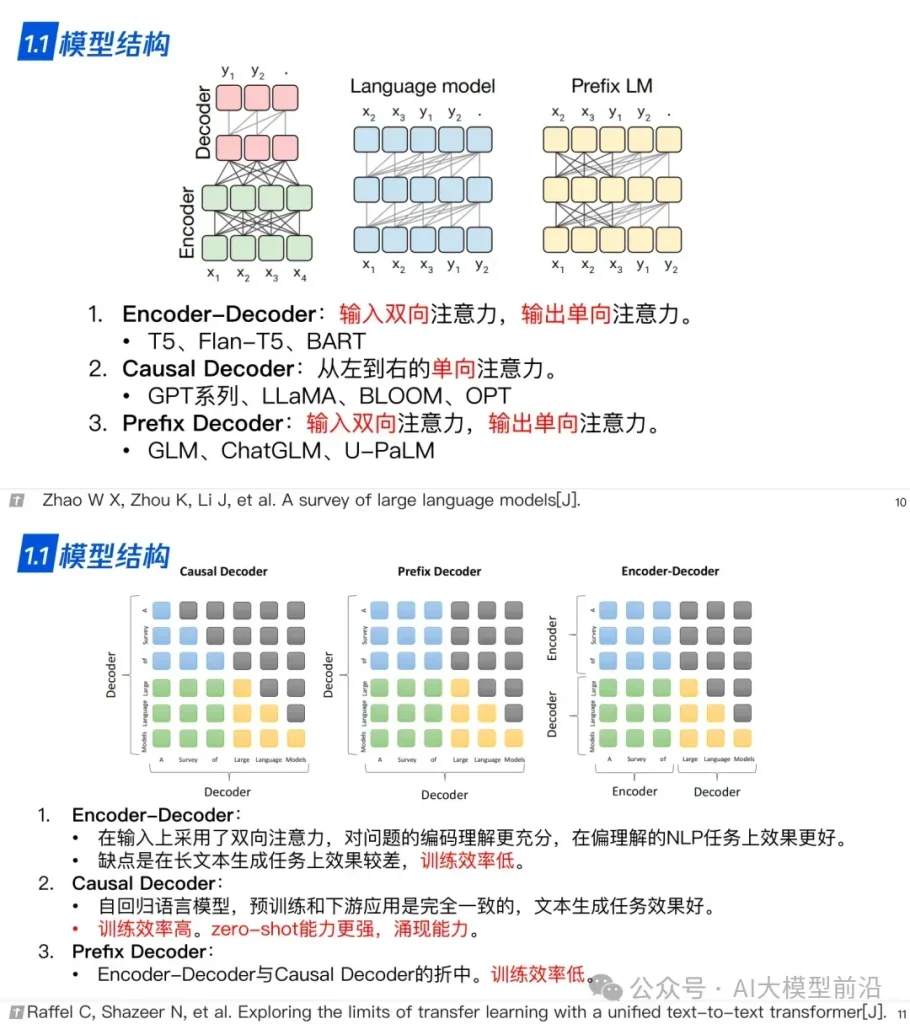

1.1 模型结构

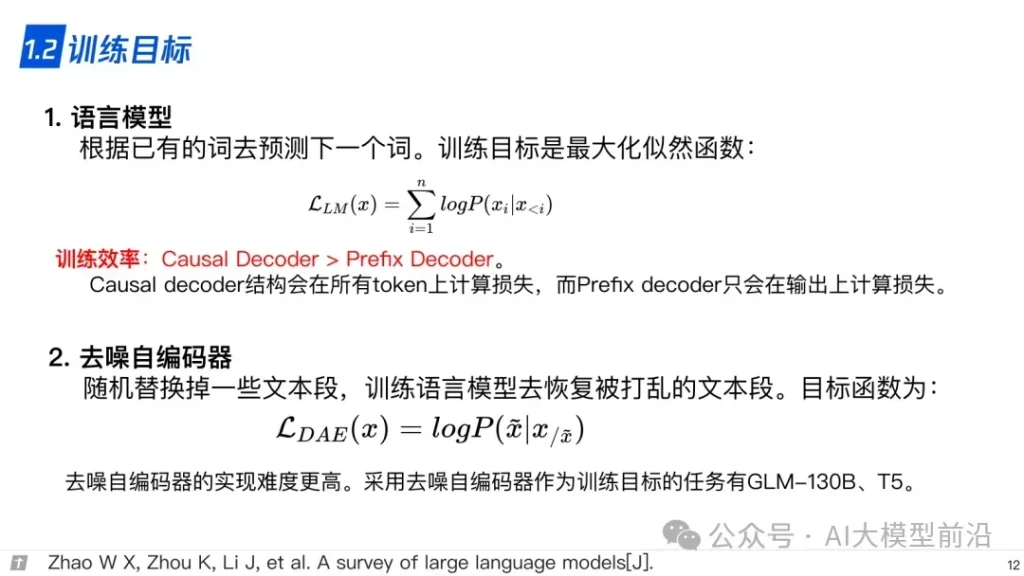

1.2 训练目标

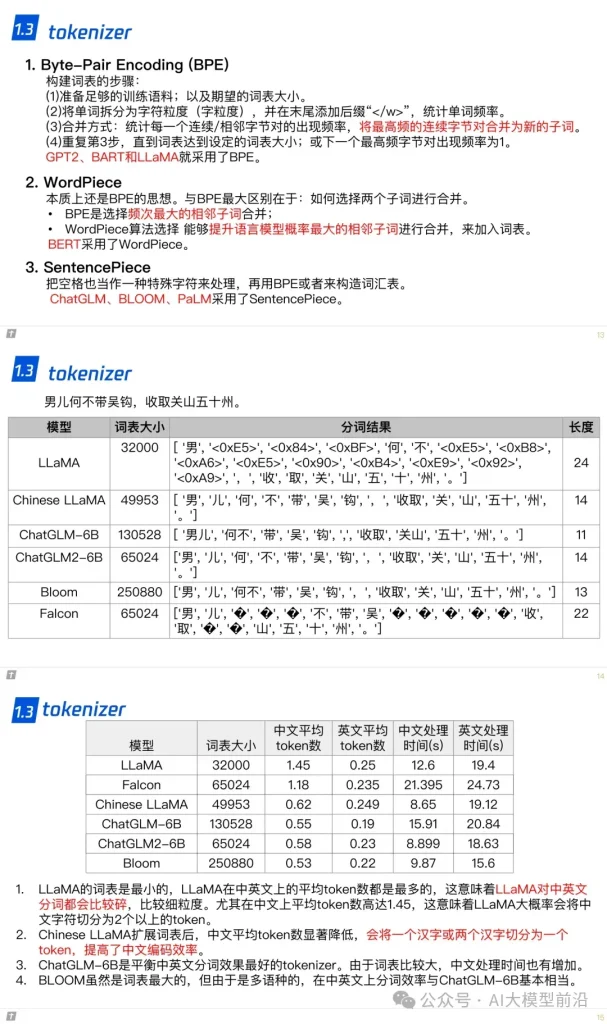

1.3 tokenizer

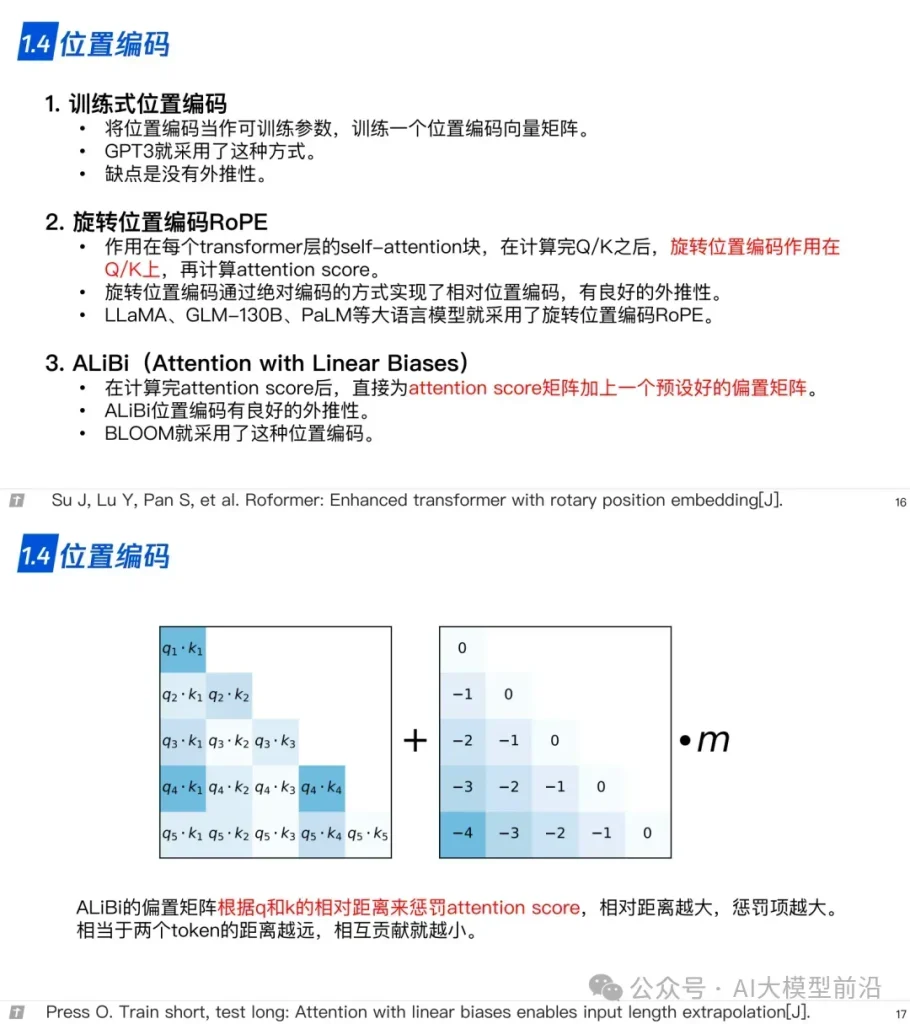

1.4 位置编码

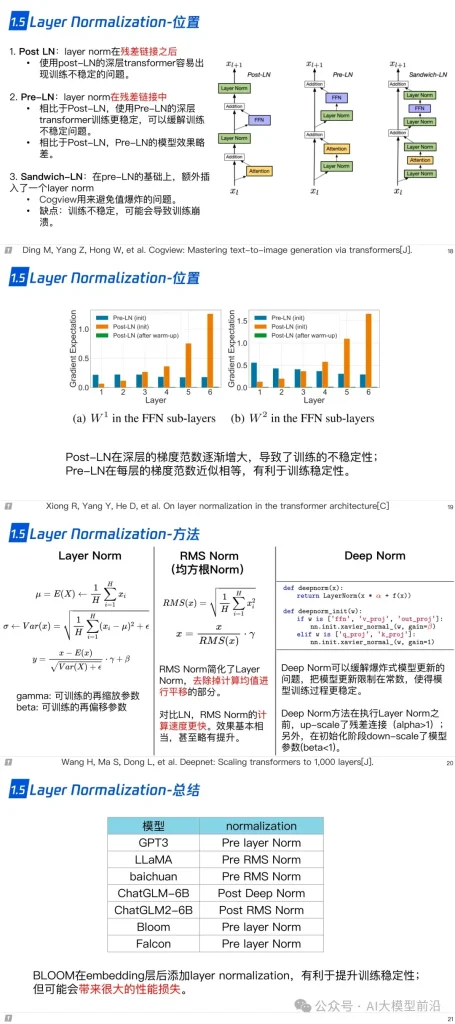

1.5 层归一化

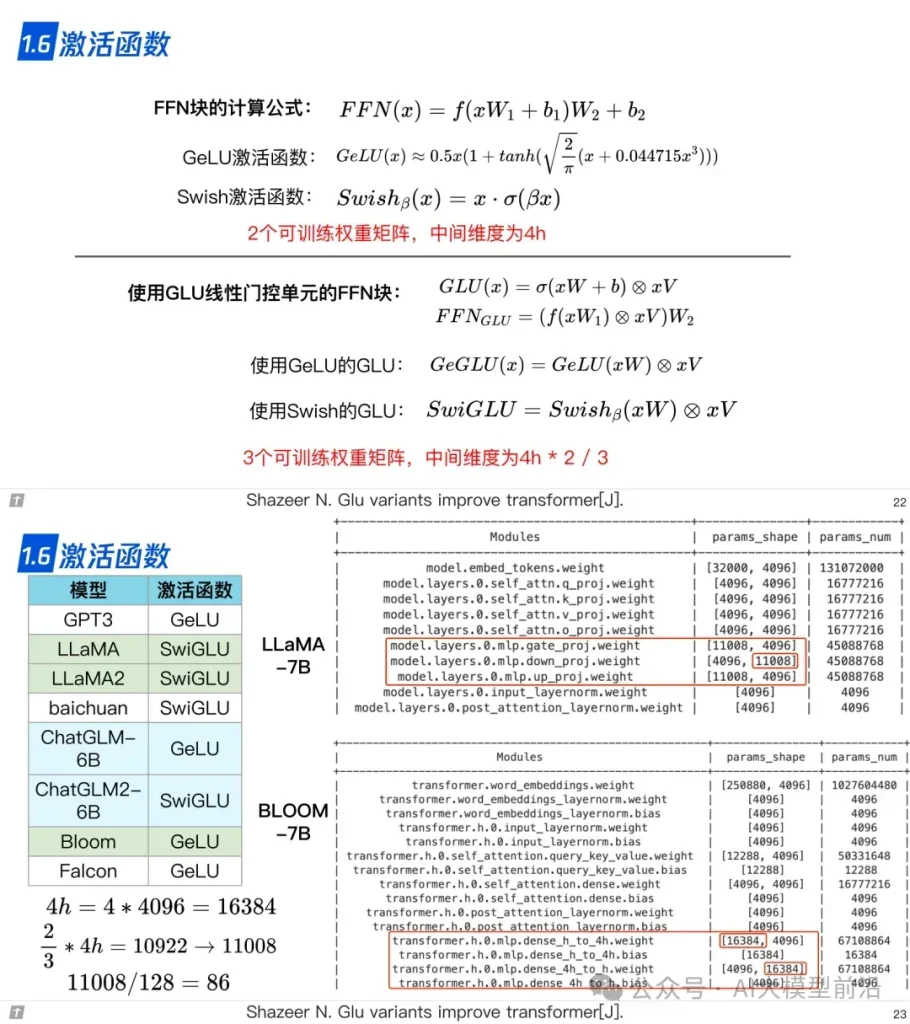

1.6 激活函数

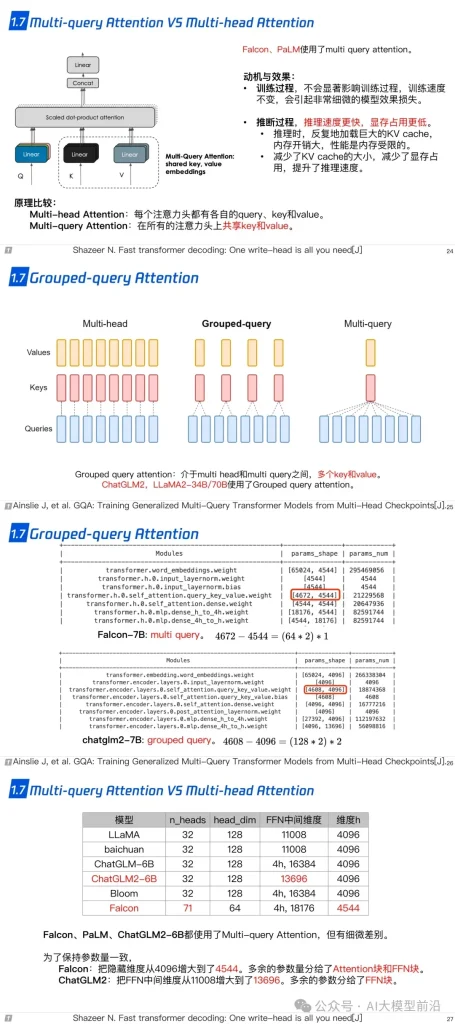

1.7 Multi-query Attention 与 Grouped-query Attention

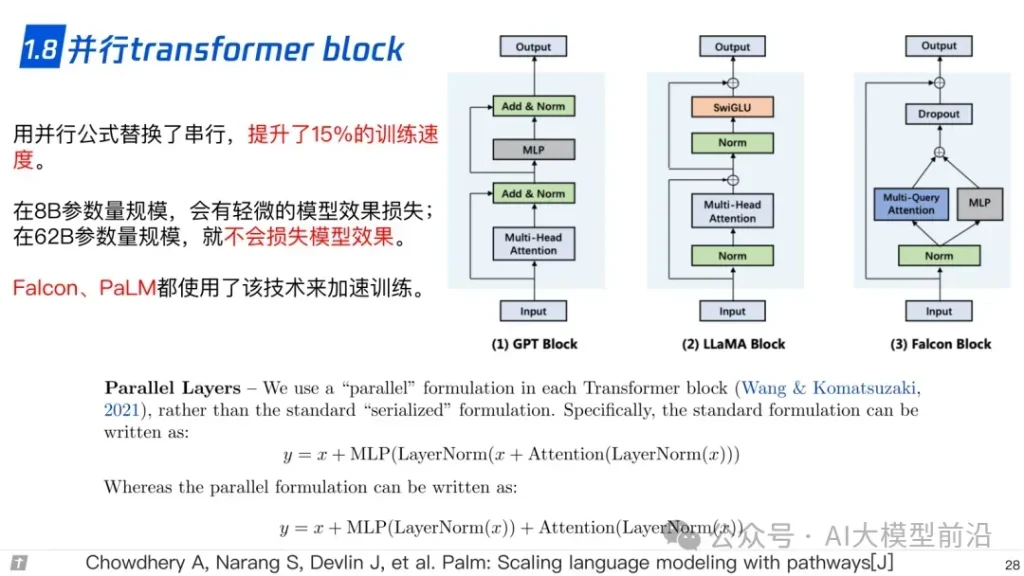

1.8 并行 transformer block

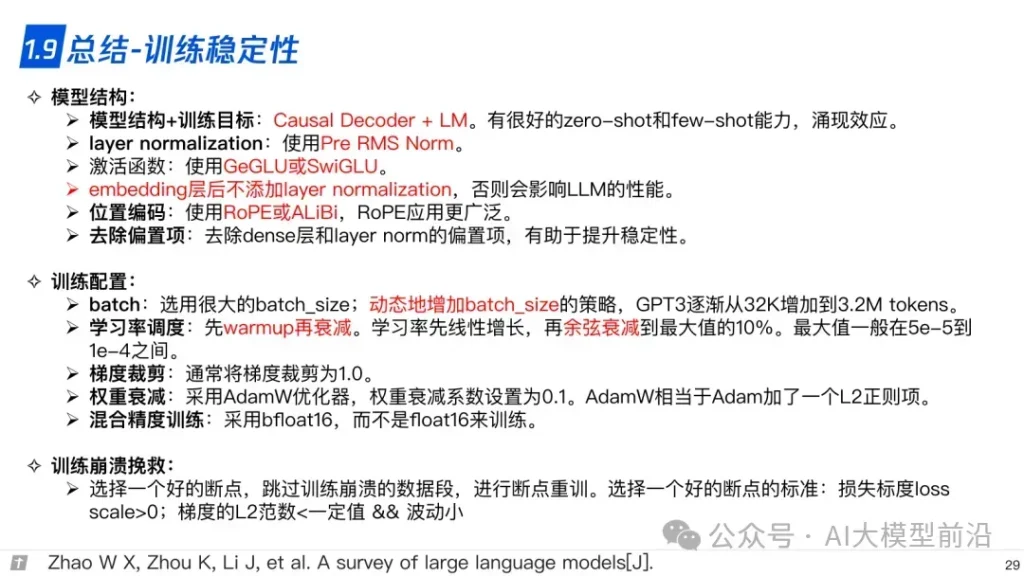

1.9 总结-训练稳定性

导读

理解大语言模型,可以从‘LLM的架构、LLL的训练、LLL的微调’三个方面进行,也可以针对需求重点理解一部分。例如,训练+微调,可以读后两篇,只做微调,读最后一篇。

- 一文说尽大语言模型技术之一:LLM的架构

- 一文说尽大语言模型技术之二:LLM的分布式预训练

- 一文说尽大语言模型技术之三:LLM的参数高效微

参考资料

原文转自: 微信公众号@AI大模型前沿

热门推荐

一个账号试用1000+ API

助力AI无缝链接物理世界 · 无需多次注册

3000+提示词助力AI大模型

和专业工程师共享工作效率翻倍的秘密

最新文章

- 如何用 OpenAPI 在 Express 中构建更好的 API

- API在社交媒体中的应用

- 实战拆解:如何使用 ChatGPT Agent 实现自动化多步骤任务

- 使用AI进行API设计

- 深入解析API Gateway:微服务架构中的关键组件及其重要功能

- 如何获取巴法云开放平台 API Key 密钥(分步指南)

- 没有中国银行卡怎么用微信支付?探索国际用户的支付新思路

- Python字典(dict)完全指南

- Java后端API接口开发规范

- PyJWT:轻松搞定Token认证,让你的API更安全!

- 2025年7月GitHub 上热门的10大API开源项目

- 构建远程医疗应用的10个最佳Telehealth API选项

热门推荐

一个账号试用1000+ API

助力AI无缝链接物理世界 · 无需多次注册