Llama 3.2 API 定价:您需要了解的一切 - Anakin.ai

随着文本处理和多模态(文本+图像)功能。无论是开发对话代理、数据处理系统,还是构建多模态应用,Llama 3.2 API 都能提供卓越的性能。而理解其定价结构对于优化特定用例的价值至关重要。

Llama 3.2 API 定价模型解析

Meta 及其合作伙伴采用 每百万 token 美元计价 的方式,不同版本的 Llama 模型根据规模和功能差异实行分级定价。这种灵活的定价模式既适用于小型应用,也能满足企业级需求。

以下是部分模型的价格示例:

Together AI 平台价格

-

Llama 3.2 Turbo (3B)

输入输出 token:0.06 美元/百万 token

-

Llama 3.2 标准版 (8B)

- 输入输出 token:0.20 美元/百万 token

- 覆盖区域:北美、欧洲、亚太

Amazon Bedrock 平台价格

虽然 Llama 模型的 token 价格总体保持在相近区间,但受基础设施投入和数据驻留要求等因素影响,不同区域的成本可能会有所波动。此外,各云服务商和 API 平台还提供超越基础 token 计价的增值服务,例如可扩展性、低延迟等功能,这些服务可能会对成本产生一定影响。

实际用例中的 Token 消耗分析

为了更好地理解 Llama 3.2 API 的计价机制,我们通过以下实际用例分析 token 消耗情况。

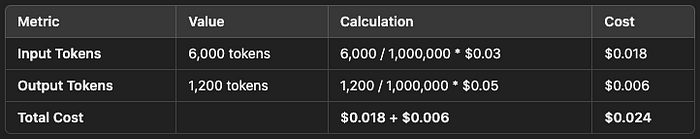

示例 1:文本摘要

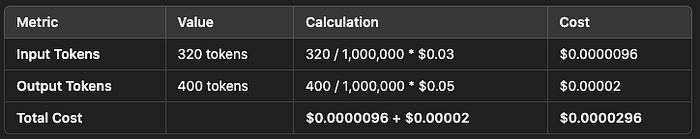

示例 2:实时聊天机器人

- 单次交互成本估算

10 万次聊天交互的总成本:

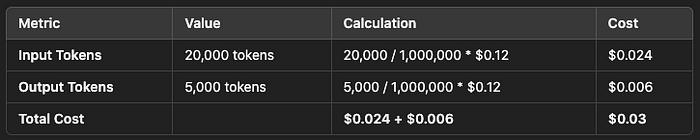

示例 3:多模态任务

- 月处理 1 万张图片的应用

总成本:0.052 美元 × 10,000 = 520 美元

-

图文处理输入

5 张图片 + 关联文本(约 2 万 token)

总成本:0.03 美元 × 10,000 = 300 美元

多模态模型的定价特点

需要注意的是,多模态模型(支持图文处理)相较于纯文本模型的价格略高。这是由于图像识别和视觉推理任务需要额外的算力。例如:

-

Llama 3.2 90B 多模态模型定价

输入输出 token:0.12 美元/百万 token(区域浮动)

与 GPT-4 等多模态方案相比,Llama 3.2 的定价更具竞争力,尤其是在封闭 API 和有限定制能力导致其他方案成本更高的情况下。

免费额度与开发者支持

多家供应商为开发者提供免费额度或返还积分,以便测试 Llama 3.2 API 的性能。例如:

- Together AI 提供免费套餐,允许开发者在升级付费服务前测试有限 token 用量。这些免费配额是中小企业或开发者在预算决策前测试模型性能的理想选择。

如何优化 Llama 3.2 API 的使用成本

掌握 Llama 3.2 API 的定价策略,能帮助开发者基于 token 用量精准规划 AI 项目预算。无论是小型应用还是大型多模态系统,Llama 3.2 都提供灵活且有竞争力的价格。关键考量因素包括:

- API 部署区域

- 特定用例的 token 需求

- 是否需要多模态处理

通过综合考虑这些因素,企业既能优化成本,又能充分释放 Llama 3.2 在各类 AI 驱动应用中的潜力。

总结

Llama 3.2 API 提供了灵活的定价模式和强大的功能,适用于各种规模的企业和开发者需求。通过深入理解其定价结构和实际用例中的 token 消耗情况,开发者可以更高效地规划预算并优化项目性能。无论是文本处理还是多模态任务,Llama 3.2 都是一个值得信赖的选择。

原文链接: http://anakin.ai/de/blog/llama-3-2-api-pricing-all-you-need-to-know/最新文章

- Kimi K2 API 调用全指南:解锁国产大模型的强大能力

- Amazon的API描述语言Smithy概述

- 向日葵开放平台:如何让远程办公和支持变得轻而易举?

- 常见的api认证方式:应用场景与优势

- AI推理(Reasoning AI)技术趋势2025:从大模型到智能体的全面升级

- Dify 全链路实战:三步搭建智能天气查询机器人(Agent+DeepSeek + 高德天气)

- 2025年GitHub开源生成式 AI API 项目盘点:Open WebUI、FastAPI LLM Server、Text Generation WebUI API

- WebSocket和REST的区别:功能、适用范围、性能与示例解析

- 9个最佳Text2Sql开源项目:自然语言到SQL的高效转换工具

- 深入解析API网关策略:认证、授权、安全、流量处理与可观测性

- GraphQL API手册:如何构建、测试、使用和记录

- 自助式入职培训服务API:如何让企业管理更上一层楼?