调整API策略应对AI动态趋势

在当今快速发展的技术环境中,人工智能 (AI) 受到广泛关注。社交媒体上,新的人工智能初创公司、快速的工程工具和大型语言模型 (LLM) 解决方案层出不穷。这并不奇怪,因为人工智能似乎如同魔法一般!例如,ChatGPT 在公开发布后的短短两个月内便吸引了 1 亿用户,迅速走红。

如今,许多人开始关注:这一波API 开发者的影响。

API 使人工智能触手可及

大公司已迅速建立专门的人工智能研究实验室,招募数据科学家来制作人工智能模型。但是,对于没有用于人工智能研究实验室的大量计算资源和 GPU 的小型实体呢?这些小型实体并不是在被动观察大公司如何利用人工智能革命。事实上,对于许多人工智能应用程序,特别是那些以自然语言为中心的应用程序,并不需要专门的人工智能研究实验室。相反,可以利用现有的公共人工智能模型和大型语言模型 (LLMs)。这意味着开发人员不必成为人工智能专家,只需精通 API 即可。通过快速工程、微调和嵌入,这些模型可以根据特定需求进行定制。

在这里,关键在于“API”。API 封装了其内容的复杂性,使所有开发人员都能访问 AI 模型,无论其在人工智能领域的专业知识如何。这种关注点的分离确保了少数数据科学家能够创建 AI 模型并将其打包为 API,从而使更多开发人员能够将这些模型集成到他们的应用程序中,打造精通自然语言处理的“智能”解决方案。结果是,API 创造了一个公平的竞争环境,让各种规模公司的开发人员都有机会使用强大的人工智能模型。

现代应用程序的 AI 和 API 模式

API 是将产品与其他产品连接的关键,特别是在人工智能领域,这种连接显得尤为重要,因为人工智能需要与不同的数据源和工具配合才能发挥作用。现代应用程序利用人工智能和 API 结合,实现“智能”功能,使其能够理解人类语言和意图,而 API 则促进数据访问和系统连接。这些技术并非孤立存在,它们的组合使用可以产生协同效应,主要有三种集成模式:

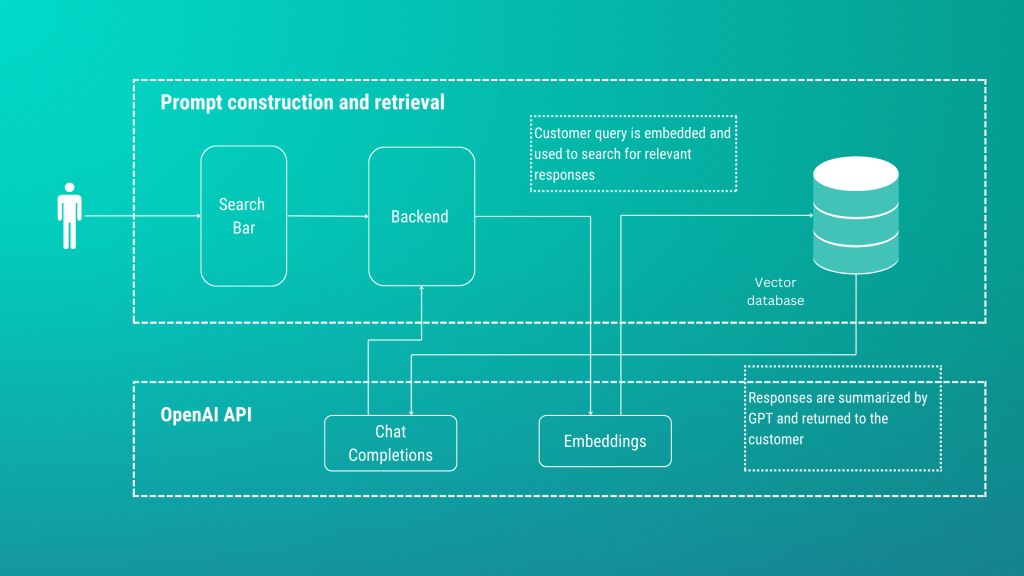

模式一:通过 API 调用 AI 服务

AI 模型(例如 OpenAI 的 ChatGPT)通常以 API 形式提供。开发人员通过这些 API 触发 AI,发送提示作为输入,从而无缝集成 AI 到应用程序中。构建新 AI 应用程序的常见架构通常利用两个 OpenAI API 端点,例如 Vector Embeddings 和 Chat Completion。该方法首先通过 OpenAI API 为每个输入文档(包括文本、图像、CSV、PDF 或其他类型的结构化/非结构化数据)创建向量嵌入。生成的嵌入会被索引以便快速检索,并保存到像向量数据库一样的存储中。这些文档将与用户的问题一起作为提示呈现给 ChatGPT,增加了 ChatGPT 智能响应用户查询的能力。

模式二:AI 服务调用 API

AI 模型响应的输出通常是文本。为了将这些输出转化为可操作的结果,人工智能服务需要调用 API。这些 API 可以在现实或数字世界中执行操作,例如付款、预约、发送消息或调整室温。API 充当人工智能服务的“双手”,使其能够与环境进行互动。ChatGPT 的自定义插件便是一个良好的例子。在这种情况下,可以使用 APISIX 为 API 网关构建自定义插件,APISIX 位于 API 的前端,负责将 AI 请求路由到预期的后端 API 服务。同时,可以实施身份验证、授权和速率限制等安全措施,或缓存来自 API 的类似响应,从而收集有关 API 使用情况、性能和潜在问题的宝贵见解。

模式三:AI 连接 API

多年前,要使两个软件系统或 API 进行通信,唯一的选择是手动编码,软件工程师需要创建复杂且脆弱的代码序列。这项任务仅适合开发人员,每次修改都意味着更多的编码,从而导致相互连接的代码变得复杂。

随着API 请求或响应中的条目需要关注时,通过自然语言发送警报通知。

保护 API 使用

人工智能能够调用在现实或数字世界中执行操作的 API,因此实施保障措施至关重要。这种保护措施最好在 API 管理系统级别进行,以确保负责任和安全地使用人工智能。本文探讨了 API Gateway 如何帮助 ChatGPT 插件开发人员公开、保护、管理和监控其 API 端点。

综上所述

应用程序开发中利用 AI 提供了明确的路线图。随着人工智能领域的不断发展,对 API 及其集成策略的关注将愈发重要。

最新文章

- 什么是Unified API?基于未来集成的访问

- 使用JWT和Lambda授权器保护AWS API网关:Clerk实践指南

- 宠物领养服务:如何帮流浪毛孩找到温馨的新家?

- Python调用IP地址归属地查询API教程

- Java API 开发:构建可重用的接口,简化系统集成

- Python 实现检测空气质量:实时监测城市空气污染指数

- 亚马逊礼品卡API全解析:企业激励与客户参与优化指南

- 地理实时地图:技术解析与现代应用实践

- Duolingo API 使用指南:语言学习与智能应用的融合实践

- 超级英雄尽在掌握:超级英雄数据API的超能力

- 了解API端点:初学者指南

- API版本控制:URL、标头、媒体类型版本控制