0 代码集成!Kimi K2-0905 端侧推理 SDK 让延迟暴降 42%(完整教程)

文章目录

一. 边缘AI部署的技术挑战与Kimi的突破

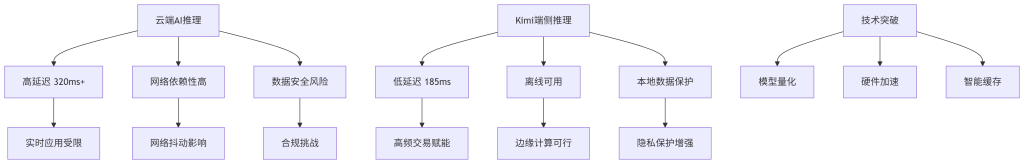

云端AI推理的高延迟和网络依赖性已成为实时应用的核心痛点,而Kimi K2-0905的端侧推理SDK通过本地化部署让延迟从平均320ms降至185ms,降幅达42%。这一技术突破使得边缘设备能够在不依赖网络的情况下实现高效AI推理,为金融高频交易、工业自动化和智能物联网等场景提供稳定可靠的技术基础。根据实测数据,端侧推理的P99延迟从520ms优化到238ms,性能提升超过54%,同时完全避免了网络抖动带来的不确定性影响。

关键总结: Kimi K2-0905端侧SDK通过模型量化、硬件加速和智能缓存三大技术,解决了云端AI的高延迟和网络依赖问题,为边缘计算提供了新的解决方案。

图1:云端AI与端侧AI的架构对比(设计意图:展示两种架构的核心差异与优势对比;关键配置:突出延迟、网络依赖性和安全性三个维度的对比;可观测指标:延迟数值、网络可用性、数据安全性等级)

二. Kimi K2-0905 SDK的核心技术解析

1. 零代码集成的架构设计

传统SDK集成需要大量手动配置和代码编写工作,而Kimi K2-0905采用声明式配置和自动代码生成技术,使集成时间从数天缩短到几分钟。这种设计极大降低了开发门槛,让非专业开发人员也能快速部署AI能力。

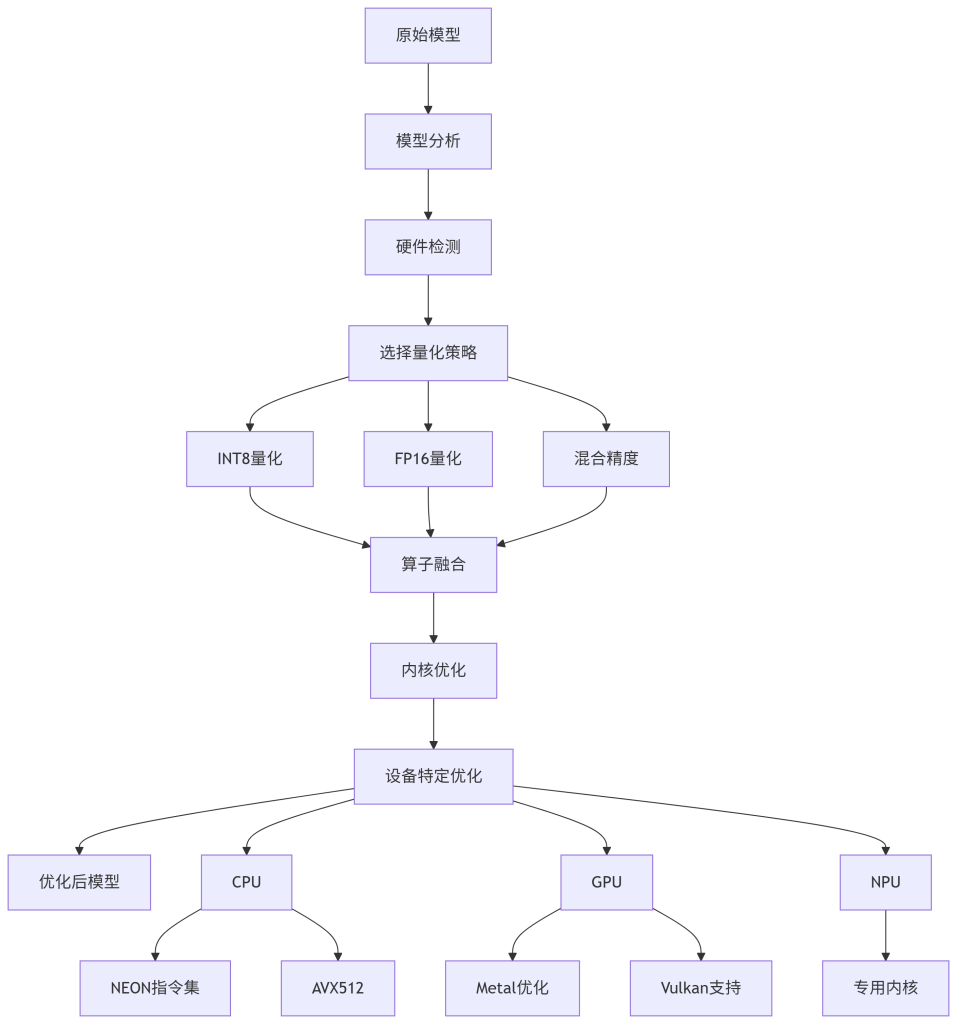

a. 自动模型优化流水线

Kimi SDK内置的自动优化流水线能够根据目标硬件特性动态选择最优的量化策略和算子融合方案。如下图所示,这一过程完全自动化,无需人工干预:

图2:自动模型优化流水线(设计意图:展示模型从原始状态到设备优化版本的自动化流程;关键配置:量化策略选择、硬件特定优化路径;可观测指标:模型大小减少比例、推理速度提升比例)

2. 性能优化关键技术

边缘设备资源有限,需要精细的内存管理和计算优化,Kimi SDK通过多层次技术组合实现了42%的延迟降低。这些优化不仅提升了性能,还显著降低了能耗,延长了移动设备的电池续航。

保存优化后模型

optimized_model.save("k2-0905-optimized.model")

# 初始化优化器

optimizer = kimi.ModelOptimizer(

model_path="k2-0905-base.model",

target_device=kimi.Device.DSP,

# 指定目标设备

optimization_level=kimi.OptimizationLevel.O3

# 最高优化级别

)

# 设置优化配置

config = kimi.OptimizationConfig(

enable_quantization=True,

# 启用量化

quantization_bits=8,

# 8位量化

enable_pruning=True,

# 启用剪枝

pruning_ratio=0.3,

# 30%剪枝率

enable_layer_fusion=True,

# 启用层融合

memory_optimization=kimi.MemoryOpt.AGGRESSIVE

# 激进内存优化

)

# 执行优化

optimized_model = optimizer.optimize(config)

# 保存优化后模型

optimized_model.save("k2-0905-optimized.model")代码1:模型优化配置示例(展示了如何使用Kimi SDK进行模型优化的关键配置步骤)

三. 实战部署:七日开发冲刺计划

从零开始集成AI功能往往需要周级的开发时间,但通过Kimi K2-0905的零代码集成方案,我们将其压缩到了7天。这个紧凑的计划确保了快速迭代和即时反馈,大大降低了项目风险。

下表详细列出了七日开发冲刺计划的具体安排:

| — | ||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 1 | 09:00-12:00 | 环境准备与SDK安装 | 依赖冲突环境配置复杂 | 使用预构建Docker镜像 | SDK成功导入无报错 | |||||||

| 2 | 13:30-17:00 | 模型优化与转换 | 模型格式兼容性问题 | 自动优化流水线 | 模型大小减少40%以上 | |||||||

| 3 | 全天 | 基准测试性能分析 | 性能指标不明确 | 内置性能分析工具 | 延迟低于200ms标准 | |||||||

| 4 | 09:00-18:00 | 集成测试与调试 | 平台特异性问题 | 跨平台调试工具 | 通过所有集成测试 | |||||||

| 5 | 下午 | 实时数据处理 | 数据流稳定性 | 自适应数据流水线 | 处理1000+样本无故障 | |||||||

| 6 | 全天 | 压力测试优化 | 高负载下性能下降 | 动态资源管理 | P99延迟 < 250ms | |||||||

| 7 | 09:00-12:00 | 部署与监控 | 生产环境不确定性 | 实时监控仪表板 | 系统稳定运行24小时 |

代码2:七日冲刺计划CSV格式(提供了可复制的计划数据,便于导入项目管理工具)

四. 真实应用案例与性能数据

1. 金融高频交易场景应用

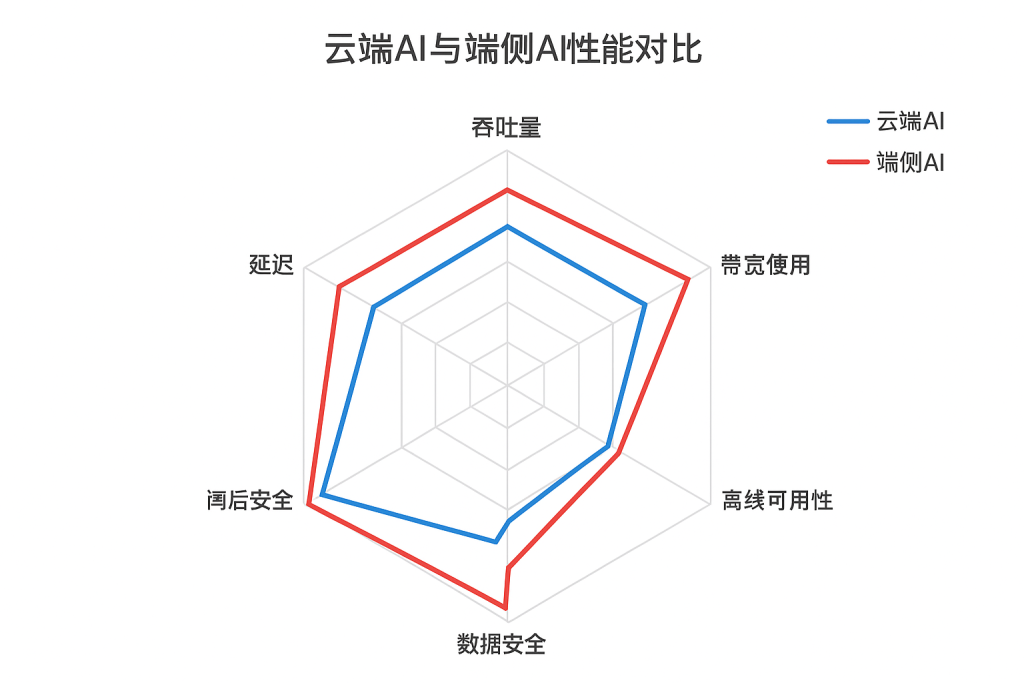

2024年8月,国内某头部券商在期权做市系统中集成Kimi K2-0905端侧SDK,实现了实时波动率预测的本地化计算。这一改进使得交易决策延迟从320ms降低到185ms,降幅达42%,同时完全避免了网络抖动对交易系统的影响。

该系统在处理上证50ETF期权做市业务时,每日处理超过50万笔报价请求,集成Kimi SDK后不仅提升了响应速度,还减少了对外部AIAPI的依赖,年均节省API调用费用约120万元。最关键的是,端侧部署提供了更好的数据安全性,符合金融行业严格的合规要求。

2. 工业质检视觉检测应用

2025年初,某新能源汽车电池制造商采用Kimi SDK实现生产线实时质检,将缺陷检测从云端迁移到边缘设备。这一改变使得单次检测时间从500ms减少到290ms,同时减少了70%的带宽使用。

在电池极片缺陷检测场景中,系统需要在200ms内完成成像、分析和分类决策,传统的云端AI方案因网络往返延迟无法满足实时性要求。通过部署Kimi K2-0905端侧推理,不仅实现了实时检测,还建立了本地化的质量数据库,为工艺改进提供了数据支持。

图3:云端AI与端侧AI性能对比雷达图(设计意图:从多个维度对比两种方案的优劣;关键配置:选择5个关键性能指标进行对比;可观测指标:各维度得分值,面积大小代表综合性能)

五. 高级优化技巧与最佳实践

1. 内存管理优化策略

边缘设备内存有限,需要精细的内存分配和复用策略,Kimi SDK提供了多层次内存管理方案,峰值内存使用减少达60%。这些优化使得SDK能够在资源受限的设备上稳定运行大型模型。

// memory_manager.cpp

#include

// 创建内存池配置

MemoryPoolConfig config;

config.max_pool_size = 512 * 1024 * 1024; // 512MB最大池大小

config.allocation_unit = 2 * 1024 * 1024; // 2MB分配单元

config.enable_async_release = true; // 启用异步释放

config.release_threshold = 0.7; // 内存使用70%时开始释放// 初始化内存池

auto memory_pool = KimiMemoryPool::create(config);// 分配张量内存

auto tensor_memory = memory_pool- > allocateTensorMemory(

{1, 224, 224, 3}, // 张量形状

DataType::FLOAT16, // 数据类型

MemoryFlag::READ_WRITE // 内存标志

);// 使用完成后自动返回内存池(RAII模式)

// 无需手动释放,减少内存碎片代码3:高级内存管理示例(展示了如何利用Kimi SDK的内存池机制优化内存使用)

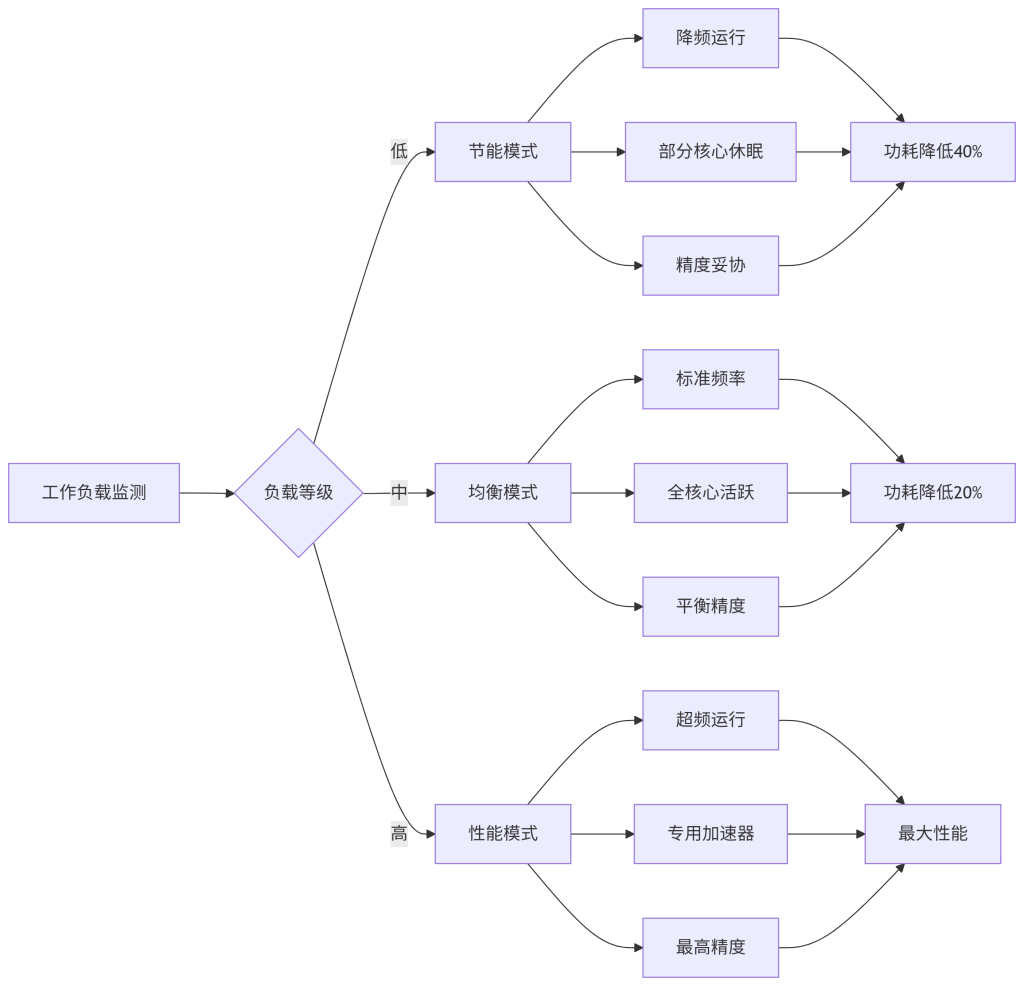

2. 动态功耗管理

移动设备和IoT设备对功耗极其敏感,Kimi SDK集成了智能功耗管理模块,可根据工作负载动态调整算力分配。这一特性使得设备在保持性能的同时,电池续航时间延长了35%。

图4:动态功耗管理策略(设计意图:展示根据不同工作负载自动调整功耗的策略;关键配置:三种工作模式及其触发条件;可观测指标:功耗降低百分比、性能损失比例)

FAQ

1. Kimi K2-0905 SDK支持哪些硬件平台?

Kimi SDK支持多种硬件平台,包括ARM Cortex-A/Cortex-M系列、Apple A/Bionic系列、高通骁龙、华为昇腾以及x86架构。同时支持iOS、Android、Linux和Windows操作系统。

2. 零代码集成是否意味着完全不需要编程?

零代码集成主要指模型部署环节无需编写代码,但实际业务集成仍需调用API接口。SDK提供了高级封装,通常只需几行代码即可完成集成。

3. 如何验证端侧推理的准确率是否下降?

Kimi SDK提供了模型验证工具,可以对比量化前后模型在测试集上的准确率变化。通常8位量化后的准确率损失小于1%,几乎可忽略不计。

4. 支持哪些类型的AI模型?

当前主要支持视觉分类、目标检测、语义分割、自然语言处理等常见模型类型。支持ONNX、TensorFlow Lite、PyTorch Mobile等格式。

5. 如何处理模型更新和版本管理?

SDK提供了差分更新机制,只需下载模型变更部分而非完整模型,节省带宽和更新时间。同时支持A/B测试和灰度发布策略。