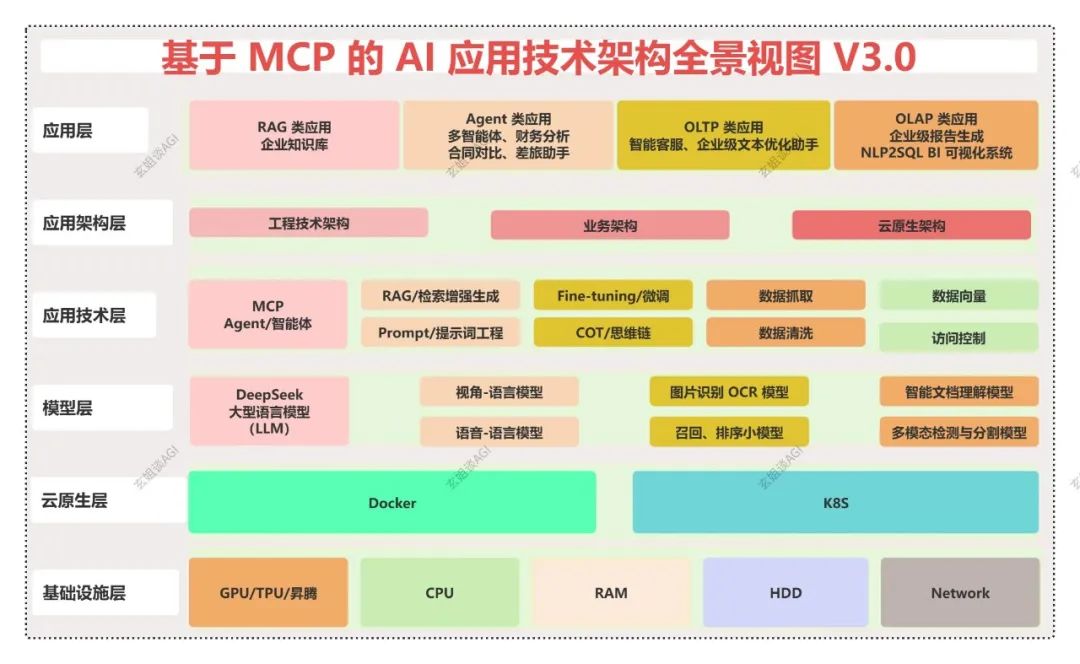

一文剖析基于 MCP 的 AI 应用技术架构全景视图:从基础实施层、云原生层、模型层、应用技术层、应用架构层、到应用层

作者:xiaoxin.gao · 2025-08-14 · 阅读时间:9分钟

本文详细介绍了基于MCP的AI应用技术架构,从基础设施层到应用层的各个技术细节。MCP作为标准协议,连接大语言模型与外部工具,提升AI应用灵活性。涵盖GPU、CPU等硬件支持,云原生弹性架构,大模型微调、RAG技术等应用实践,并提供业务架构设计建议。通过这些技术协同工作,推动AI技术落地产业应用。

基于 MCP 的 AI 应用技术架构全景图

MCP 已经成为业界的标准,基于 MCP 的 AI 应用技术已经在具体的业务场景落地实践。本文通过梳理基于 MCP 的 AI 应用技术架构的全景视图,让你全面了解 AI 应用技术的各个层次,从基础实施层、云原生层、模型层、应用技术层、应用架构层、到应用层,如下图所示,揭示基于 MCP 的 AI 应用技术如何在不同的层面上协同工作,推动产业应用的落地。

一、基础设施层

AI 大模型技术发展离不开坚实的基础设施支持,涵盖了 GPU、CPU、RAM、HDD、Network 等关键硬件设施。这些硬件设备为 AI 大模型的训练与推理提供了关键的运算资源和存储能力。

1.1、GPU(图形处理单元)的作用

- GPU 针对并行计算进行了优化,非常适合深度学习以及执行复杂计算任务。

- 与传统 CPU 相比,GPU 在处理大规模数据时具有显著优势,特别是在图像处理和神经网络训练领域。

1.2、CPU(中央处理单元)的重要性

- CPU 作为通用处理器,承担了大部分的计算任务。

- 虽然在并行处理方面不及 GPU,但 CPU 在执行逻辑运算和控制任务时表现高效,构成了计算机系统的关键部分。

1.3、RAM(随机存取存储器)的功能

- RAM 提供了计算过程中快速读写数据的临时存储空间。

- 其主要职责是存放正在运行的程序和数据,使得 CPU 能够迅速访问这些信息,从而提升整体的计算效率。

1.4、HDD(硬盘驱动器)的角色

- HDD 承担着存储大量训练数据和模型文件的任务。

- 尽管其访问速度不及 RAM,但 HDD 凭借较大的存储容量,成为长期保存数据的主要设备。

1.5、Network(网络)的角色

- Network 为 AI 大模型的预训练、微调、推理、应用访问提供分布式的通信基础设施。

二、云原生层

2.1、弹性伸缩层

- 基于 Docker 容器和 K8S 的弹性云原生架构,为 AI 大模型的预训练、微调、推理以及 AI 应用的部署,提供了高扩展、高可用的云环境,从而根据访问量的情况动态伸缩。

三、模型层

这一层主要由大语言模型、视觉-语言模型、小模型等构成。

3.1、大语言模型(LLMs)

3.2、视觉-语言模型的融合

- 视觉-语言模型结合了视觉与语言信息,能够理解和创造跨模态内容。

- 这种模型不仅能够处理文字信息,还能识别和生成图像、视频等视觉内容,广泛应用于图像标注、视频解析等领域。

3.3、智能文档理解的实现

- 智能文档理解技术通过解析文本和非结构化数据,实现对文档内容的深入理解。

- 它能够自动抓取关键信息,执行文档的分类和提炼工作,从而为文档管理及信息检索提供智能化支持。

3.4、多模态检测与分类的技术

- 多模态检测与分类技术整合了多种数据类型,以实现更精确的分类和检测。

- 通过融合文本、图像、音频等多种模态的信息,该技术提升了模型的精确度和稳健性,并在安全监控、医疗诊断等多个领域得到了广泛应用。

四、应用技术层

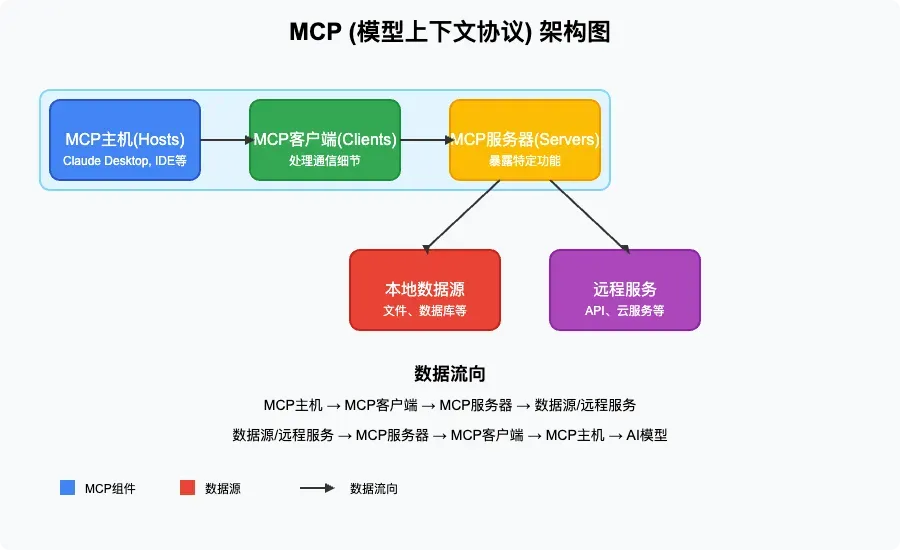

4.1、MCP 技术

MCP(Model Context Protocol)是由 Anthropic 公司提出的一种协议,旨在解决不同大语言模型(LLM)与不同外部工具集成的标准化问题。

- 通过 MCP,开发者能够以一种统一的方式将各种数据源和工具连接到 AI 大模型,从而提升大模型的实用性和灵活性。

目前,MCP 生态已经得到了广泛的支持,包括 Anthropic 的 Llama 系列、DeepSeek、阿里的通义系列以及 Anysphere 的 Cursor 等主流模型均已接入 MCP 生态。

第一、MCP 的架构设计

MCP 采用了客户端-服务器架构,主要包括以下几个核心组件:

-

MCP 主机(Hosts)

- 角色:需要访问数据的程序,例如 Claude Desktop、各种 IDE 或 AI 工具。

- 功能:它们是 MCP 生态系统的入口点,负责向用户提供 AI 功能,并作为用户与 AI 模型之间的桥梁。

-

MCP 客户端(Clients)

- 角色:协议客户端,负责维持与 MCP 服务器的 1:1 连接。

- 功能:处理通信细节,确保主机和服务器之间的数据传输顺畅,从而实现高效的数据交互。

-

MCP 服务器(Servers)

- 角色:轻量级程序,每个服务器都通过标准化的 Model Context Protocol 暴露特定功能。

- 功能:连接 AI 大模型与实际数据源,使模型能够访问和操作数据。

-

数据源

- 本地数据源:包括您计算机上的文件、数据库和服务,MCP 服务器可以安全地访问这些资源。

- 远程服务:通过互联网可用的外部系统(比如:通过 API),MCP 服务器可以连接这些系统,从而扩展模型的能力。

4.2、Agent(智能体)技术

- Agent 智能体技术就是利用大模型的推理能力对任务进行规划拆解,并使用外部的工具完成一件复杂的任务。

4.3、RAG(检索增强生成)技术

- RAG 技术融合了检索与生成两种方法,旨在提升信息生成的精准度。

- 它利用检索到的相关信息来增强生成模型的效能,确保所生成内容的准确性与相关性。

4.4、大模型微调(Fine-tuning)

- 大模型微调技术通过对模型进行细致调整,使其更好地适应特定任务需求。

- 在特定任务的数据集上进行微调后,模型在相关任务上的性能可以得到显著提升,实现更精准和高效的处理。

4.5、提示词工程(Prompt Engineering)

- 提示词工程专注于设计高效的提示语,以优化模型的输出结果。

- 通过精心设计的提示词,可以引导模型生成更加符合预期的内容,从而提升生成文本的质量。

4.6、思维链(Chain-of-Thought)技术

- 思维链技术模拟人类的思考过程,以增强模型的决策和推理能力。

- 通过逐步推理和决策,该技术使得模型能够更有效地处理复杂问题,并做出更加合理的判断。

4.7、数据工程技术

- 在应用技术层,还涵盖了数据抓取、清洗、构建向量库、实施访问控制等数据处理的全流程。

- 这些环节确保了数据的质量和安全,这些基础步骤对于模型的训练和推理至关重要,它们有助于增强模型的性能和信赖度。

五、应用架构层

5.1、工程技术架构

- 通过工程技术架构的设计解决 AI 应用高可用、高性能、高可靠。

5.2、业务架构

- 针对业务场景选择合适的业务架构类型(RAG 架构、AI Agent 架构等选型)。

5.3、云原生架构

- 解决 AI 应用弹性伸缩。

六、应用层

6.1、增量应用

- AI 应用的增量应用主要分为 RAG 类应用、Agent 类应用。

6.2、存量应用

-

AI 应用的存量应用主要分为 OLTAP 类应用、OLAP 类应用。

-

热门推荐

一个账号试用1000+ API

助力AI无缝链接物理世界 · 无需多次注册

3000+提示词助力AI大模型

和专业工程师共享工作效率翻倍的秘密

最新文章

- gRPC 与 REST:API 开发方法的对比分析

- 如何使用 OpenAI 的 Sora API:综合使用指南

- 如何使用 amazon scraper api 进行商品数据采集

- 推荐一款支持加入数据库的AI项目:让你的数据库秒变AI数据库!

- 什么是 API Key 密钥以及如何使用它们?

- API 身份验证与授权:OAuth2、JWT 与最佳实践

- 支付宝财富黑卡权益是什么?如何充分利用这些权益?

- API Settings详解:如何通过配置优化API性能与安全性

- 使用 OpenAPI 和 Prism 模拟回调

- Jenkins API使用教程

- 如何通过MCP+魔搭免费API搭建本地数据助手

- api如何重塑在线教育与教育科技领域