阿里通义 ModelScope 应用代码:全面指南与实践

文章目录

ModelScope 的概述

ModelScope 是一个由机器学习模型。它通过丰富的API设计,使开发者能够轻松执行模型的推理、训练和评估,从而在不同AI领域之间提供统一的模型体验。ModelScope 为开发者和模型贡献者提供了一个开放的生态系统,支持多种AI应用场景。

如何在 ModelScope 上下载模型

模型下载的步骤

要在 ModelScope 上下载模型,用户需要通过平台提供的API接口进行操作。以下是一个下载模型的代码示例:

from modelscope.models import Model

model = Model.from_pretrained('thomas/m3e-base')这样即可将模型自动下载到本地缓存目录中,方便后续调用和使用。

模型下载的注意事项

在下载模型时,用户需确保本地环境已安装必要的依赖库,并根据需求选择合适的模型版本。此外,合理规划本地存储空间,避免因模型文件过大导致的磁盘空间不足问题。

ModelScope 的安装与配置

安装步骤

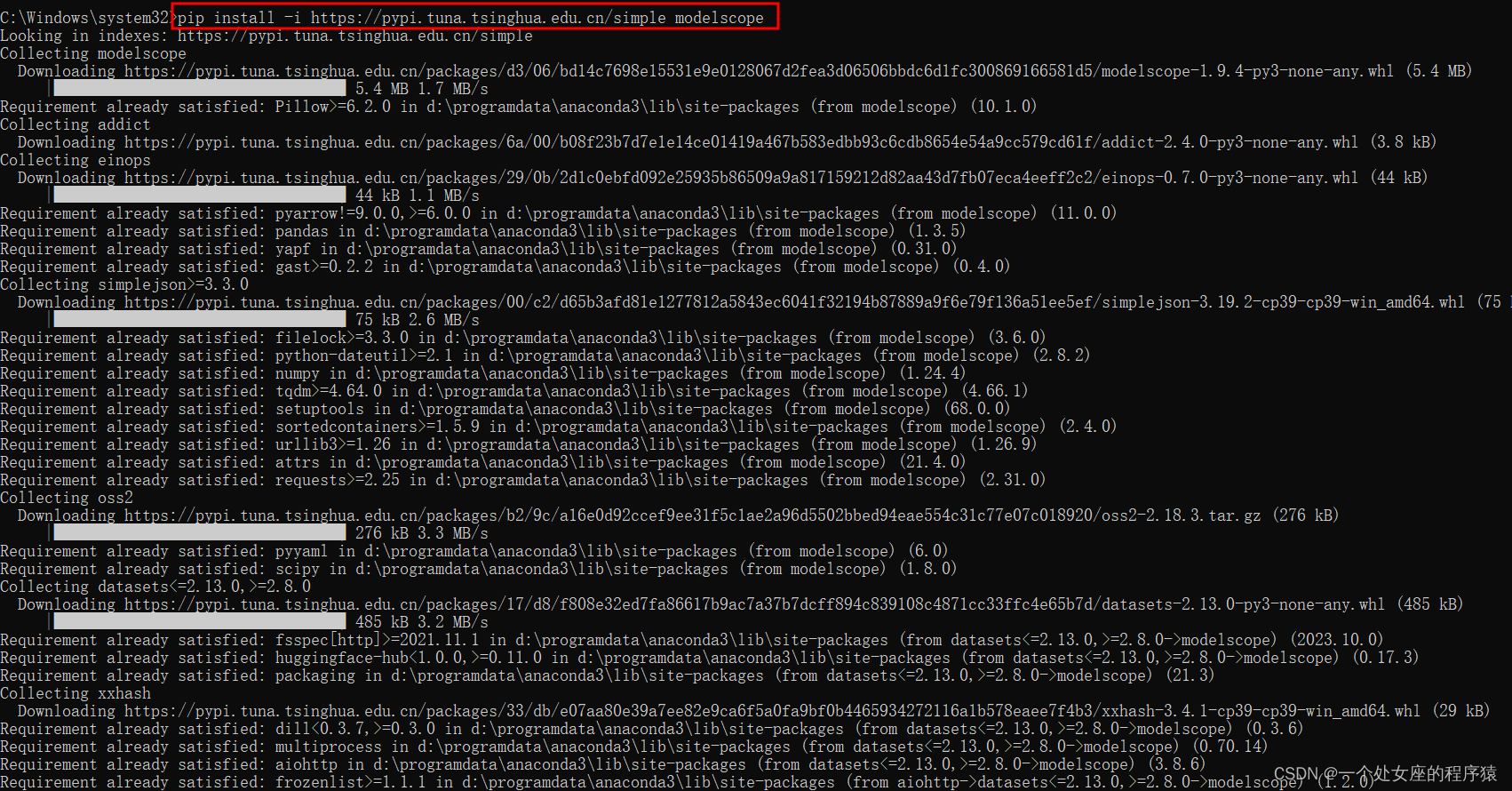

ModelScope 的安装相对简单,用户可以通过 pip 命令直接安装:

pip install modelscope对于特定领域的模型需求,还可以安装相关领域的依赖:

pip install modelscope[nlp] -f https://modelscope.oss-cn-beijing.aliyuncs.com/releases/repo.html环境配置

安装完成后,需要进行环境配置,如设置环境变量和安装必要的运行时库。特别是对于 Windows 用户,需要注意 OpenSSL 版本的匹配,以确保代码的正常运行。

使用 ModelScope 进行模型推理

基础用法

使用 ModelScope 进行模型推理非常直观。以下是一个简单的推理代码示例:

from modelscope import AutoModelForCausalLM, AutoTokenizer

device = "cuda"model = AutoModelForCausalLM.from_pretrained(

"qwen/Qwen1.5-0.5B-Chat-GPTQ-Int4",

device_map="auto"

)

tokenizer = AutoTokenizer.from_pretrained("qwen/Qwen1.5-0.5B-Chat-GPTQ-Int4")prompt = "给我一份上海旅游的旅行计划"

text = tokenizer.apply_chat_template([

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": prompt}

], tokenize=False, add_generation_prompt=True)

model_inputs = tokenizer([text], return_tensors="pt").to(device)response = model.generate(model_inputs.input_ids, max_new_tokens=512)

print(tokenizer.batch_decode(response, skip_special_tokens=True)[0])进阶用法

对于需要多轮对话的场景,可以通过以下代码实现:

def multi_dialogue():

model, tokenizer = initialize_dialogue()

dialogue_state = {"history": [], "current_round": 0}

while True:

user_input = input("请输入您的问题或指令,或输入 'quit' 以结束对话:")

if user_input.lower() == "quit":

break dialogue_state["history"].append({"role": "user", "content": user_input})

prompt = "".join([message["content"] for message in dialogue_state["history"]])

response = generate_response(model, tokenizer, prompt, dialogue_state["history"])

dialogue_state["history"].append({"role": "system", "content": response})

dialogue_state["current_round"] += 1 print(f"助手回复:{response}")ModelScope 的应用场景

自然语言处理

ModelScope 提供了丰富的自然语言处理模型,涵盖文本分类、情感分析、翻译等多个领域。开发者可以根据项目需求选择合适的模型进行应用,快速实现复杂的NLP任务。

计算机视觉

在计算机视觉领域,ModelScope 提供了多种预训练模型,如图像分类、目标检测和图像生成等。这些模型经过优化和验证,能够以较高的精度和效率处理视觉数据。

环境搭建和常见问题

Windows 环境搭建

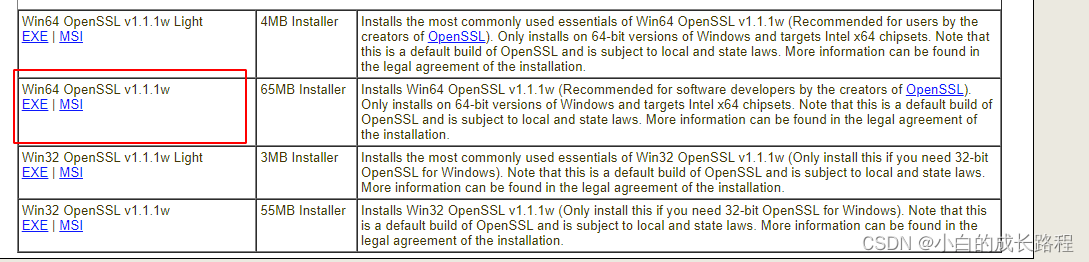

对于 Windows 用户,环境搭建可能需要额外的步骤,如安装 OpenSSL 和配置环境变量。以下是配置 OpenSSL 的步骤:

- 下载并安装 OpenSSL。

- 将 OpenSSL 的安装路径添加至环境变量 Path。

-

在命令行中验证安装是否成功: “`bash

openssl version

### 常见问题与解决方案

在使用 ModelScope 的过程中,可能会遇到一些常见问题。例如,OpenSSL 版本不匹配导致的错误可以通过更新安装解决。对于其他问题,建议查阅 ModelScope 的官方文档或社区支持。

## FAQ

### ModelScope 支持哪些编程语言?

ModelScope 主要[Python](https://www.explinks.com/blog/ua-python-shi-shi-m-quan-mian-fen-xi-python-de-shi-jie/) 生态系统设计的。

### 如何解决 OpenSSL 的安装问题?

确保下载适合操作系统版本的 OpenSSL 安装包,并正确配置环境变量。如果问题依旧,建议检查系统更新或联系技术支持。

### 是否需要 GPU 才能运行 ModelScope?

虽然 GPU 能够加速模型的训练和推理,但 ModelScope 也支持在 CPU 上运行。不过,性能可能会有所下降。

### ModelScope 是否支持自定义模型?

是的,ModelScope 支持用户上传自定义模型,并通过平台提供的接口进行托管和调用。

### 如何获取更多 ModelScope 的使用案例?

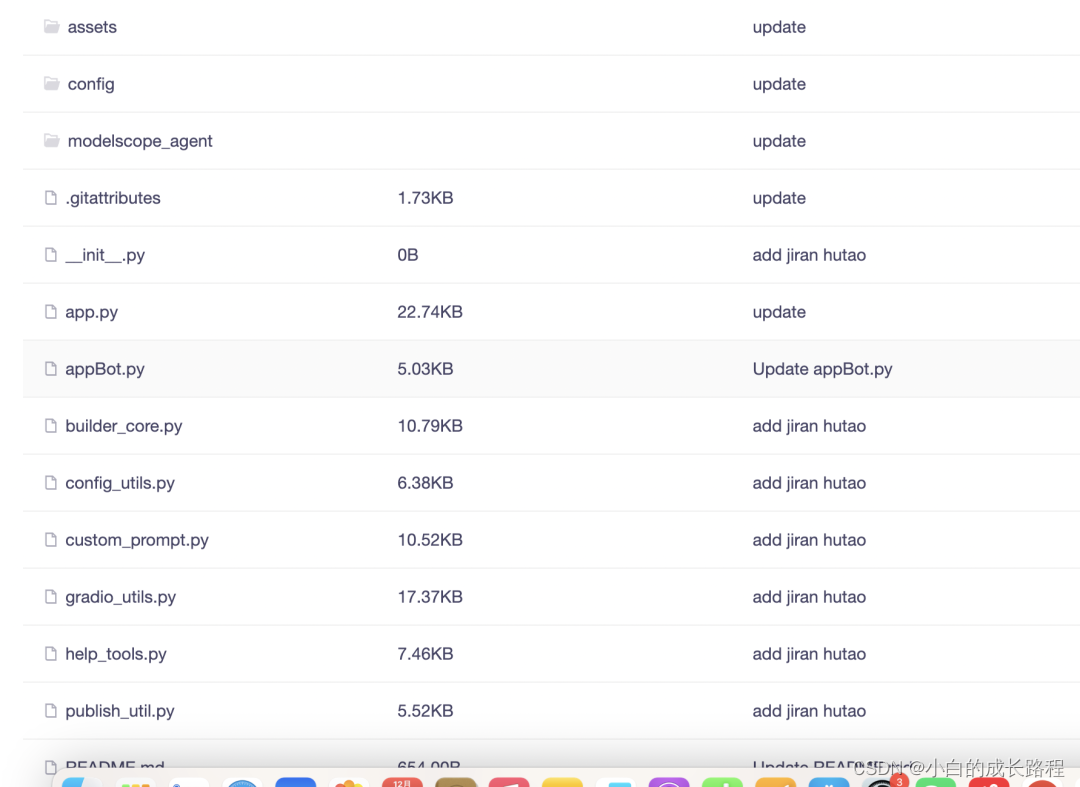

可以访问 ModelScope 的官方社区和 GitHub 仓库,获取最新的使用案例和用户分享。

通过这篇文章,我们详细探讨了[阿里通义 ModelScope](https://www.explinks.com/blog/ua-rag-system-based-on-ali-tongyi-modelscope) 的应用和使用方法,希望能为有志于 AI 模型开发的读者提供有价值的参考。最新文章

- 2026大学生寒假兼职新风口:从送外卖到做AI副业,你还在靠体力赚零花钱吗?

- 如何获取Microsoft API Key 密钥实现bing搜索分步指南

- Google Pay UPI 注册与集成指南

- 香港支付宝可以绑定大陆银行卡吗?详解使用方法与步骤

- New API架构:探索现代软件开发的新趋势

- 什么是 Wandb

- 在 Golang 中实现 JWT 令牌认证

- 如何使用 Google News API 获取实时新闻数据

- Google DeepMind发布 Genie 3与Shopify:2小时上线电商3D样板间实战

- FLUX.1 Kontext API 使用完全指南:解锁文本驱动的智能图像编辑

- 如何防范User-Agent信息伪装引发的API访问风险

- 苹果支付流程:从零开始的接入指南