Dify.AI 专家模式指南:高效提示编排与 AI 应用优化

自成立以来,Dify.AI 一直致力于为开发者提供更灵活、更高效的即时编排控制。为了实现这一目标,我们推出了一种全新的提示编排模式。只需在提示编排页面上从“基本模式”切换到“专家模式”,即可开启一段全新的提示编排探索之旅。

模式概述

专家模式是专为大语言模型(LLM)或数据集进行稳健可靠的交互。

从基础到专家:提示编排的进阶之路

基本模式旨在降低用户创建 AI 应用程序的门槛,允许用户快速配置和生成简单的应用程序。然而,这种模式在一定程度上限制了提示编排的灵活性。而专家模式则赋予用户更高的控制权和自定义能力。

在专家模式下,用户可以自由编辑提示的各个组成部分,包括上下文、用户输入、对话历史、示例等,从而精准引导模型生成所需的输出结果。无论是会话类应用还是文本生成类应用,专家模式都提供了丰富的工具和选项,帮助用户设计更复杂的提示编排。

如果用户已经在基本模式中完成了提示编排,切换到专家模式后,可以查看基本模式中封装的完整提示,并对其进行自由修改。这种灵活性使得用户能够快速调整提示内容,优化 AI 应用程序的性能,确保其输出符合预期。

专家模式的核心功能

自定义提示的灵活性

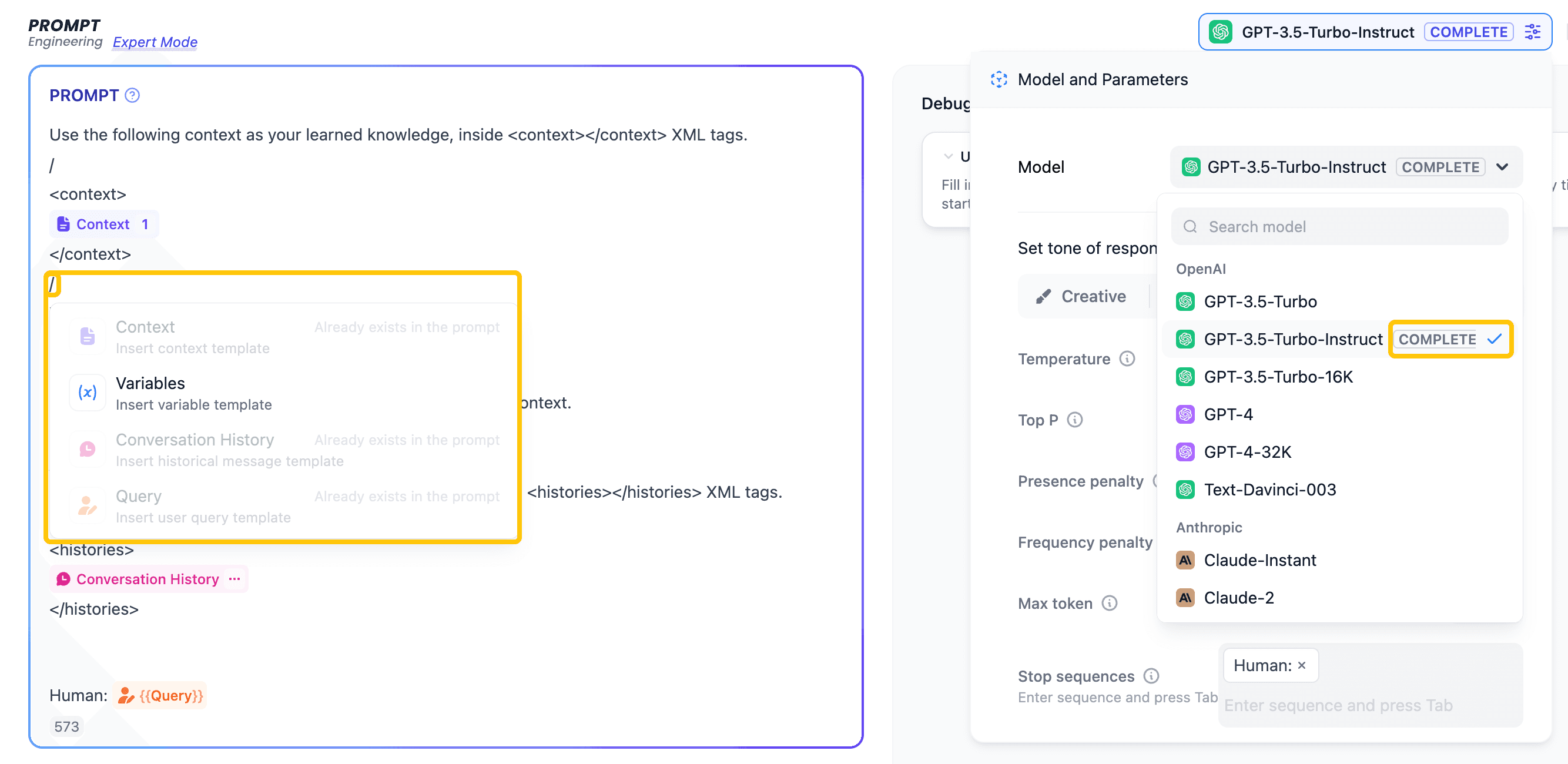

在专家模式中,用户可以根据所选模型类型(CHAT 或 COMPLETE)灵活调整提示内容:

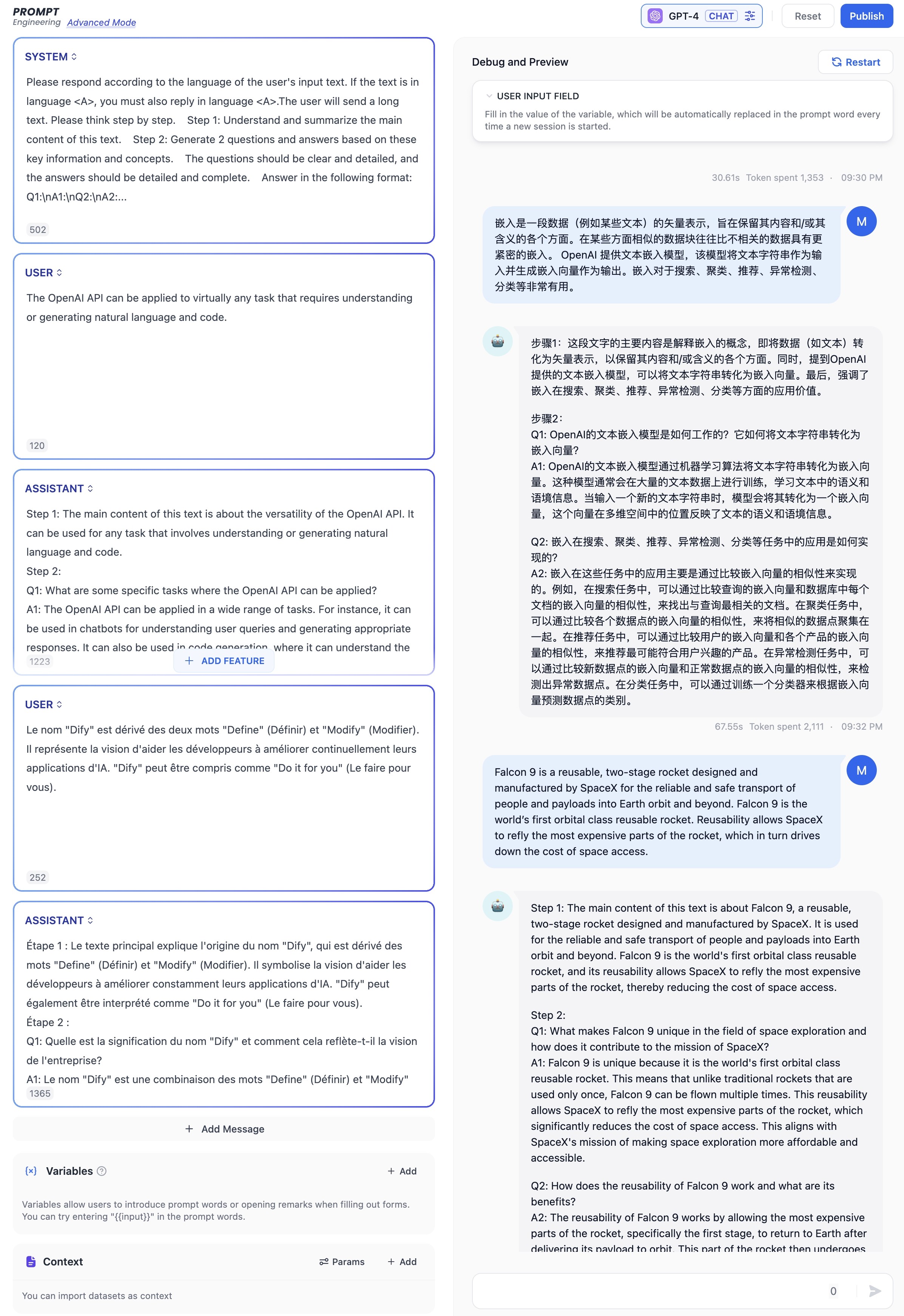

- CHAT 模型:支持为 SYSTEM、USER 和 ASSISTANT 三种消息类型分别编写提示。

- COMPLETE 模型:允许用户调整提示中的 Context、Conversation History、Query 和 Variables 等模块。

通过模块化的方式编排 USER 和 ASSISTANT 的交互信息,用户可以有效引导模型生成符合预期的输出结果。

应用实例:从文本生成 QA 对

以一个从文本生成多个问答对的应用程序为例,用户可以通过提供多组 USER 和 ASSISTANT 的交互示例,为模型提供清晰的指导。这样,模型在回答问题时会严格遵循 SYSTEM 提示的约束。这种方法类似于设置模板,确保模型以固定格式输出结果。

这种方式不仅适用于生成问答对,还可以扩展到其他场景,通过具体的提示设计实现对 AI 应用响应的精确指导,从而提升提示编排的效率和准确性。

提示调试与优化

专家模式还提供了强大的调试工具,例如“日志视图”功能。用户可以通过该功能深入分析从输入到输出的整个过程,快速定位问题来源:

- 模型解析错误:帮助用户识别模型在理解提示时可能存在的问题。

- 提示质量问题:及时调整提示内容,优化模型的输出质量。

通过这些工具,用户可以不断优化应用程序的性能,确保生成结果的准确性和可靠性。

安全性与敏感词过滤

为了确保生成内容的安全性,专家模式支持过滤用户输入和模型输出中的敏感词。这一功能使得 AI 应用程序的内容生成更加安全、可控。

总结

专家模式为提示编排提供了更高的灵活性和控制力,使开发者能够设计出更复杂、更高效的提示方案。无论是优化模型输出,还是提升应用程序性能,专家模式都为开发者提供了强大的支持。通过模块化的提示设计和详细的调试工具,用户可以快速调整提示内容,确保模型输出符合预期。

如果想了解更多关于专家模式的使用方法和最佳实践,请参考官方文档。

原文链接: https://dify.ai/blog/mastering-new-prompt-orchestration-in-dify-ai最新文章

- Python + BaiduTransAPI :快速检索千篇英文文献(附源码)

- Nexus API 的入门教程与使用指南

- API 规范:设计与最佳实践

- Undetectable检查AI API的使用指南

- 深度解析思维链Prompt(Chain-of-Thought Prompt):激发大模型推理能力的关键技术

- DeepSpeed-Chat 模型训练实战

- 使用NestJS和Prisma构建REST API:身份验证

- 教育革命:在App中集成ChatGPT API…

- 什么是OpenAPI?深入探讨API开发

- API性能:响应时间 vs 吞吐量,哪个更重要?

- API 是否应该采用语义化版本控制?

- WordPress REST API 内容注入漏洞分析