Mistral-Large-Instruct-2407 写代码:全面指南

文章目录

Mistral-Large-Instruct-2407 是一款在自然语言处理领域表现不俗的大型语言模型,其在多语言支持和高级函数调用方面的能力尤为显著。本文将详细介绍如何部署和使用 Mistral-Large-Instruct-2407,包括代码实例、常见问题解答,以及部署过程中可能遇到的坑。

部署 Mistral-Large-Instruct-2407 的方法

部署 Mistral-Large-Instruct-2407 需要一定的硬件支持,经笔者测试,至少需要四张 A800 显卡才能运行。以下是详细的配置步骤:

CUDA_VISIBLE_DEVICES=0,1,2,3 python -m vllm.entrypoints.openai.api_server

--model /data/models/Mistral-Large-Instruct-2407/

--served-model-name aaa

--trust-remote-code

--tensor-parallel-size 4

--port 8000部署完成后,您可以通过标准的 OpenAI 接口访问该模型。以下是使用示例代码:

from langchain.chat_models import ChatOpenAI

from langchain.schema import HumanMessage

llm = ChatOpenAI(

streaming=True,

verbose=True,

openai_api_key='none',

openai_api_base='http://10.11.12.13:8000/v1',

model_name='aaa'

)

output = llm([HumanMessage(content='你好')])

print(output.content)性能测试

为了验证 Mistral-Large-Instruct-2407 的能力,我们使用了 GPT-4 曾经翻车的问题“9.11 和 9.9 哪个大?为什么?”进行测试。结果显示,模型能够正确回答 9.11 大于 9.9 ,但推理过程有待优化。

常见的部署坑

最大 Token 限制

Mistral-Large-Instruct-2407 官方宣称支持最大 128k tokens,但实际测试中,配置文件 config.json 显示最大支持 32k tokens。超出此限制将导致以下错误:

BadRequestError: Error code: 400 - {'object': 'error', 'message': "This model's maximum context length is 32768 tokens. However, you requested 74761 tokens in the messages, Please reduce the length of the messages.", 'type': 'BadRequestError', 'param': None, 'code': 400}函数调用支持不足

目前 vllm 不支持 Mistral-Large-Instruct-2407 的函数调用功能,尽管官方测评中显示其函数调用能力很强。这已在 vllm 官方提出需求。

CSG-Wukong-Chinese-Mistral-Large2-123B 的改进

CSG-Wukong-Chinese-Mistral-Large2-123B 是 Mistral-Large-Instruct-2407 的改进版,通过微调,模型在中文自然语言处理任务上表现卓越。模型的语义理解、上下文关联和生成质量有显著提升。

训练细节

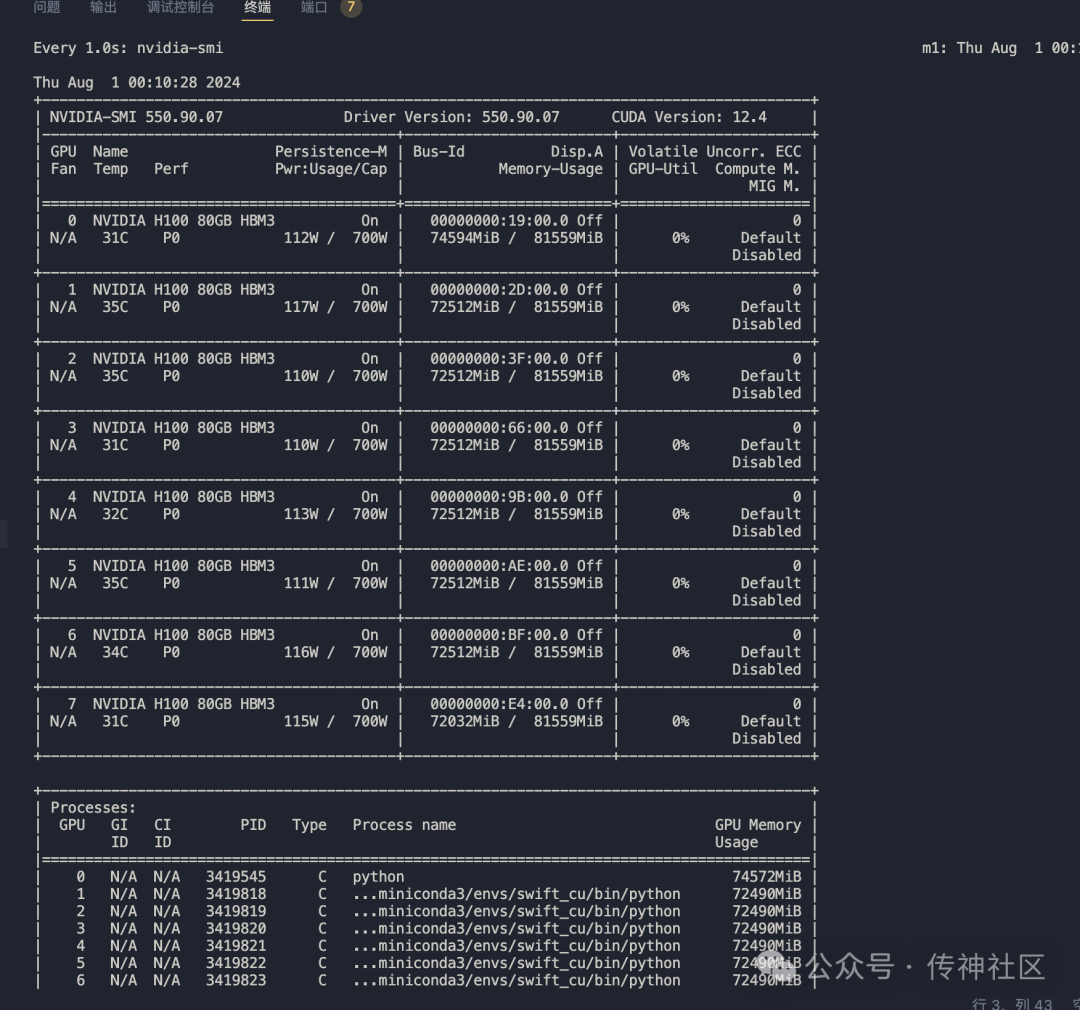

训练过程中使用了两台 NVIDIA H100 显卡,显存使用稳定。下图展示了单台显卡的显存使用情况:

推理效果

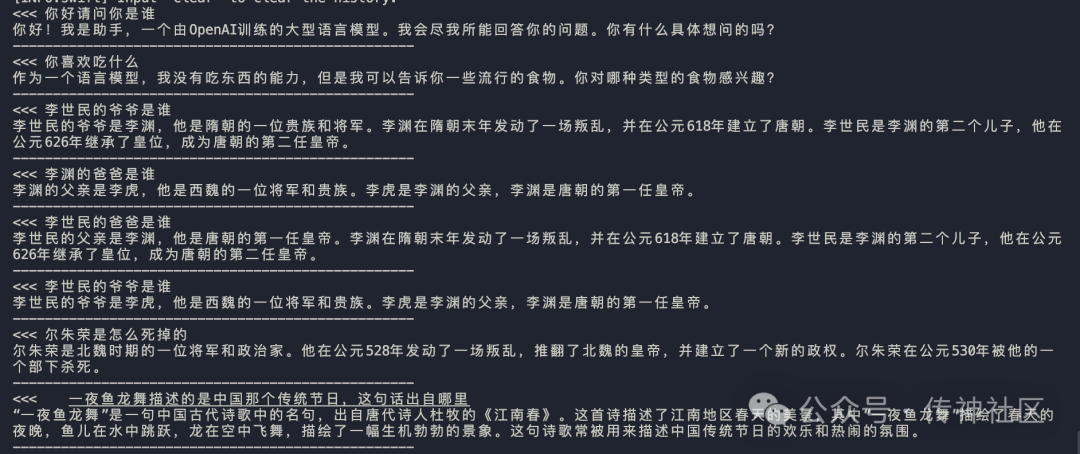

在推理阶段,CSG-Wukong-Chinese-Mistral-Large2-123B 展示了卓越的性能,以下是生成的对话示例:

模型下载与社区参与

OpenCSG 开源社区已开放了微调后的 CSG-Wukong-Chinese-Mistral-Large2-123B 模型供大家下载使用。欢迎开发者加入社区,分享经验,推动大型语言模型的发展。

模型下载地址:OpenCSG 模型下载

FAQ

1. 如何解决最大 token 限制的问题?

- 答:目前模型最大支持 32k tokens。建议优化输入文本,确保在该限制内。

2. Mistral-Large-Instruct-2407 支持哪些语言?

- 答:该模型支持多种语言,中文能力尤为突出,适合处理中文自然语言处理任务。

3. 部署 Mistral-Large-Instruct-2407 需要哪些硬件?

- 答:至少需要四张 A800 显卡才能运行。

4. 如何处理函数调用支持不足的问题?

- 答:由于 vllm 暂不支持函数调用,可以关注官方更新或提出需求。

5. CSG-Wukong-Chinese-Mistral-Large2-123B 的主要改进是什么?

- 答:主要是在中文自然语言处理任务上的表现提升,包括语义理解、上下文关联和生成质量。

最新文章

- 如何获取Microsoft API Key 密钥实现bing搜索分步指南

- Google Pay UPI 注册与集成指南

- 香港支付宝可以绑定大陆银行卡吗?详解使用方法与步骤

- New API架构:探索现代软件开发的新趋势

- 什么是 Wandb

- 在 Golang 中实现 JWT 令牌认证

- 如何使用 Google News API 获取实时新闻数据

- Google DeepMind发布 Genie 3与Shopify:2小时上线电商3D样板间实战

- FLUX.1 Kontext API 使用完全指南:解锁文本驱动的智能图像编辑

- 如何防范User-Agent信息伪装引发的API访问风险

- 苹果支付流程:从零开始的接入指南

- 全面掌握 OpenAPI 规范:定义、生成与集成指南