Mistral-Large-Instruct-2407 应用代码详解与实践

文章目录

Mistral-Large-Instruct-2407 模型概述

2024年7月,AI领域迎来了一次重要发布,Mistral-Large-Instruct-2407 模型的推出引起了广泛关注。这个模型以其高效的参数配置和卓越的性能在多个领域中脱颖而出,尤其是在代码生成、推理和数学运算方面表现优异。其支持中文的能力,更是让中国的开发者感到兴奋,这在大型语言模型中并不常见。

Mistral-Large-Instruct-2407 的发布不仅仅是参数和性能的提升,更是对多语言环境下自然语言处理能力的全面增强。它在中文自然语言处理任务中展现了更高的准确性和生成质量,成为开发者在处理复杂文本分析和生成任务时的强大工具。

使用 Mistral-Large-Instruct-2407 的部署指南

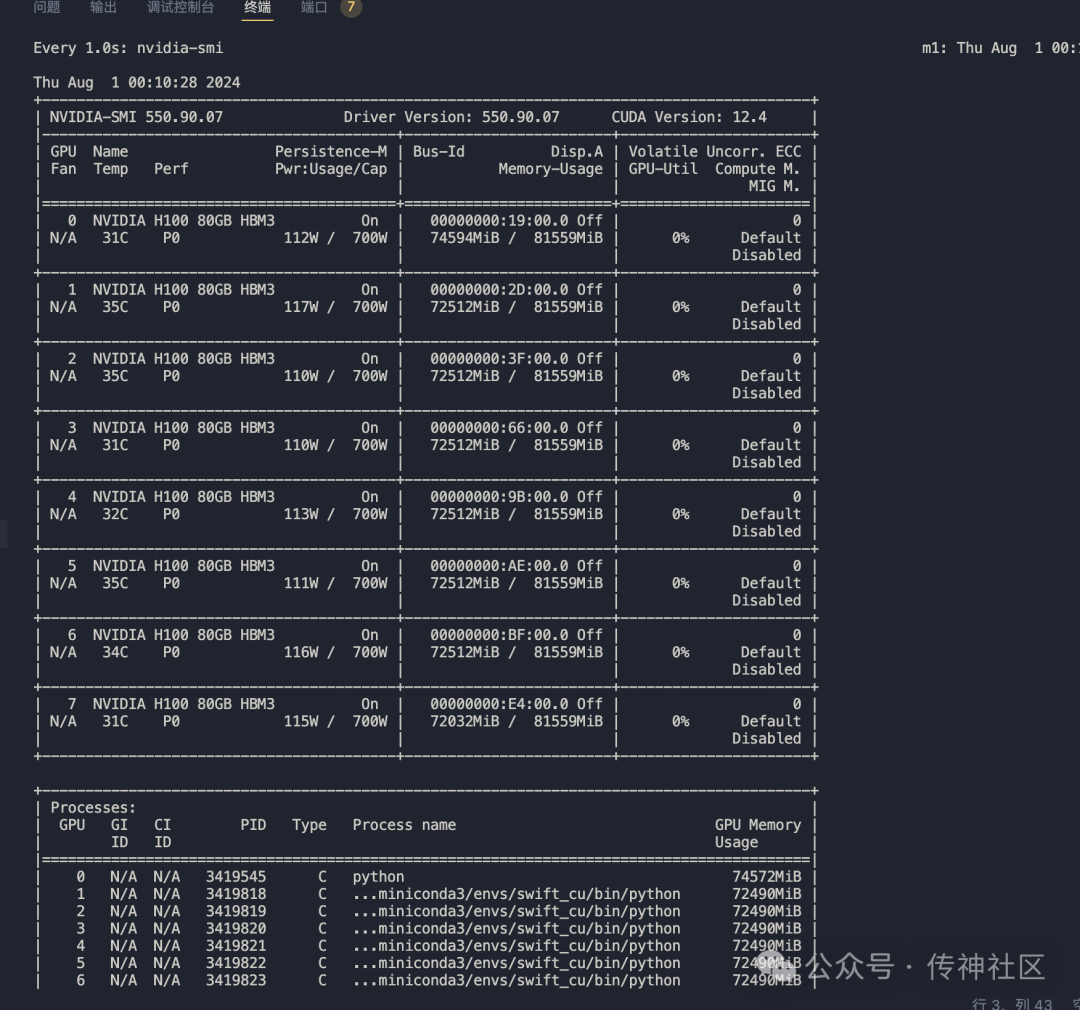

在部署 Mistral-Large-Instruct-2407 时,推荐的硬件配置是使用4张A800显卡,以确保模型能够充分发挥其潜力。以下是部署该模型的详细步骤:

CUDA_VISIBLE_DEVICES=0,1,2,3 python -m vllm.entrypoints.openai.api_server

--model /data/models/Mistral-Large-Instruct-2407/

--served-model-name aaa

--trust-remote-code

--tensor-parallel-size 4

--port 8000部署成功后,可以通过标准的OpenAI接口来访问此模型。这种部署方式不仅提高了模型的可用性,还使得在不同系统上的集成变得更加便捷。

Mistral-Large-Instruct-2407 的测试与性能评估

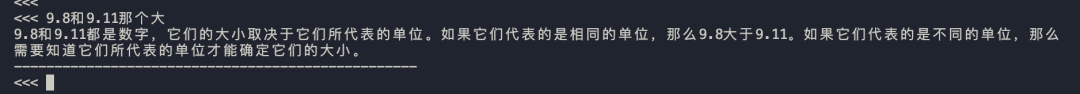

为了测试 Mistral-Large-Instruct-2407 的性能,我们使用了一个经典的问题:“9.11和9.9哪个大?为什么?”。以下是模型的回复:

9.11 比 9.9 大。

原因如下:

1. 比较整数部分:9.11 和 9.9 的整数部分都是 9,所以它们相等。

2. 比较小数部分:9.11 的小数部分是 0.11,而 9.9 的小数部分是 0.9。

3. 将小数部分转换为相同的单位进行比较:0.11 = 11 个 0.01,而 0.9 = 90 个 0.01。

4. 比较 11 个 0.01 和 90 个 0.01:显然,9.11 比 9.9 多了 0.01。尽管模型给出的结论正确,但在推理过程中出现了一些小错误,例如“9.11 比 9.9 多了 0.01”的部分。尽管如此,这并不影响模型在其他应用场景中的表现。

部署过程中可能遇到的问题

最大token限制问题

Mistral-Large-Instruct-2407 官方宣称支持最大128k的token,但在实际测试中发现,模型的 config.json 中的参数配置显示 "max_position_embeddings": 32768。这意味着,目前放出的模型最大token仅支持32k。超出这个限制的请求会导致以下错误:

BadRequestError: Error code: 400 - {'object': 'error', 'message': "This model's maximum context length is 32768 tokens. However, you requested 74761 tokens in the messages, Please reduce the length of the messages.", 'type': 'BadRequestError', 'param': None, 'code': 400}这一问题在社区中也引发了广泛讨论,目前官方还未给出明确的解决方案。

函数调用支持问题

尽管 Mistral-Large-Instruct-2407 在函数调用能力上表现优异,但 vllm 部署目前不支持该功能。对此,社区用户已经向 vllm 官方提交了功能请求,希望能够在未来的版本中实现此功能。

CSG-Wukong-Chinese-Mistral-Large2-123B 的改进与应用

CSG-Wukong-Chinese-Mistral-Large2-123B 是基于 Mistral-Large-Instruct-2407 的一个重要变种,经过微调后在中文处理任务上表现更为出色。其训练数据涵盖了大量高质量的中文文本,使得模型在多种语境下生成自然、流畅的文本。

CSG-Wukong-Chinese-Mistral-Large2-123B 的推理效果

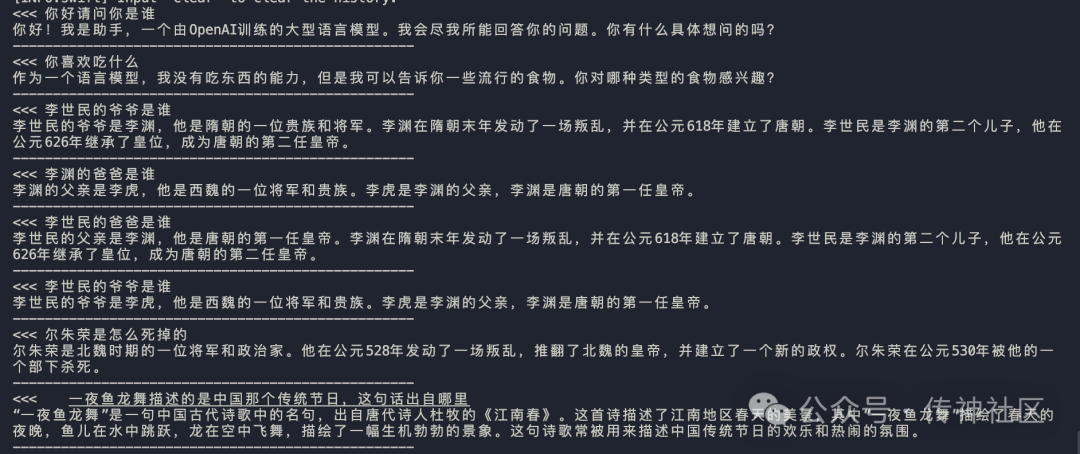

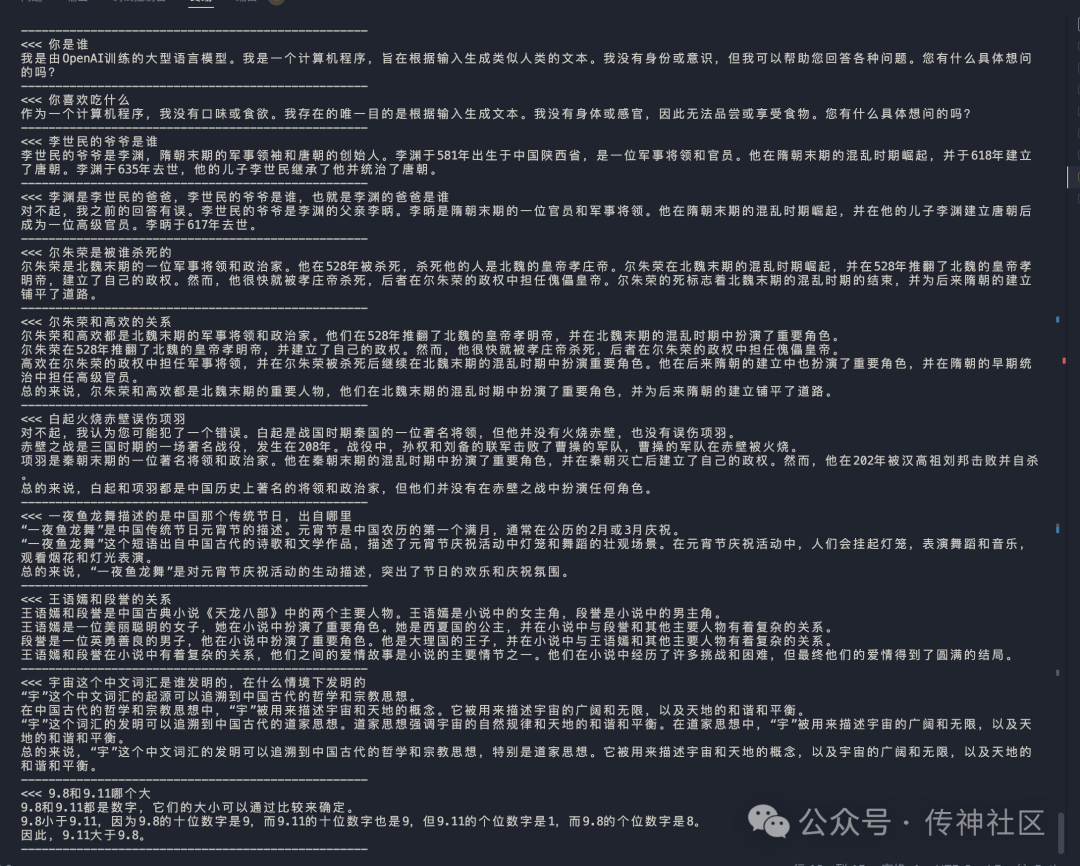

在推理阶段,CSG-Wukong-Chinese-Mistral-Large2-123B 展示了卓越的性能和效果。以下是模型在推理过程中生成的对话示例:

通过与 Llama3.1-405B 中文版的对比,我们可以看出,CSG-Wukong-Chinese-Mistral-Large2-123B 在对话生成的流畅性、语义理解的准确性和上下文关联性方面均表现出色。

模型下载与社区支持

通过本次微调,Mistral-Large-Instruct-2407 模型的中文能力得到了显著提升。开发者和研究人员可以通过以下链接下载模型,并加入OpenCSG社区,共同探索大型语言模型的应用和发展。

-

Github主页:OpenCSG GitHub

-

Huggingface主页:OpenCSG Huggingface

FAQ

-

问:Mistral-Large-Instruct-2407 支持多少种语言?

- 答:Mistral-Large-Instruct-2407 支持多种语言,尤其具备较强的中文处理能力。

-

问:如何解决最大token限制的问题?

- 答:目前最大token限制为32k,开发者需确保请求不超过该限制,或等待官方更新。

-

问:CSG-Wukong-Chinese-Mistral-Large2-123B 的主要优势是什么?

- 答:其经过微调后在中文任务上表现优异,包括语义理解和上下文关联能力的提升。

-

问:如何参与 OpenCSG 社区?

- 答:可以通过访问 OpenCSG 的 GitHub 或加入社区用户交流群来参与。

-

问:Mistral-Large-Instruct-2407 的应用场景有哪些?

- 答:该模型适用于代码生成、对话生成、文本分类等多种自然语言处理任务。

最新文章

- API性能:响应时间 vs 吞吐量,哪个更重要?

- API 是否应该采用语义化版本控制?

- WordPress REST API 内容注入漏洞分析

- 智能旅行API:你的完美旅行规划助手

- 大模型新基座,基于FastAPI,利用Python开发MCP服务器

- Google DeepMind发布 Genie 3 API架构解析:24fps流式3D世界协议

- 把 C# 里的 HttpClient 封装起来,告别复杂的配置,让 Restful API 调用更轻松更高效

- 释放Spring Boot API中数字签名的强大功能

- 如何使用ChatGPT JavaScript API,3个简单步骤

- 如何通过 SEO rank API 进行竞争对手分析

- PromptPay二维码支付是什么?

- 实时航班追踪背后的技术:在线飞机追踪器的工作原理