AI视频剪辑工具:解锁创作的无限可能

GPT4ALL是一个强大的开源生态系统,它允许用户在本地运行大型语言模型,从而在保护隐私的同时享受高性能的语言处理能力。本文将详细介绍GPT4ALL的设置过程、使用方法,并探讨其在实际应用中的案例。

GPT4ALL是一个跨平台的软件,提供了一个隐私友好的环境,让用户能够在自己的计算机上运行和部署大型语言模型。这些模型可以用于聊天、文档处理等多种应用场景。GPT4ALL支持CPU和主流GPU,使其在多种硬件上都能发挥作用。

GPT4ALL不断更新,带来了一系列新功能。例如,最近的更新包括了对GGUF文件格式的支持,使得用户能够更便捷地加载和运行模型。此外,Nomic Vulkan的发布使得在NVIDIA和AMD GPU上进行本地LLM推断成为可能。

GPT4ALL的以下特点使其在众多LLM软件中脱颖而出:

GPT4ALL不仅能够作为一个聊天软件客户端使用,还提供了Python和TypeScript绑定,使得开发者可以基于此扩展功能。此外,LocalDocs功能允许用户将文件索引并与模型对话,Docker容器化部署则提供了HTTP接口,方便集成到其他应用中。

对于想要深入了解GPT4ALL技术细节的用户,可以查阅以下技术报告:

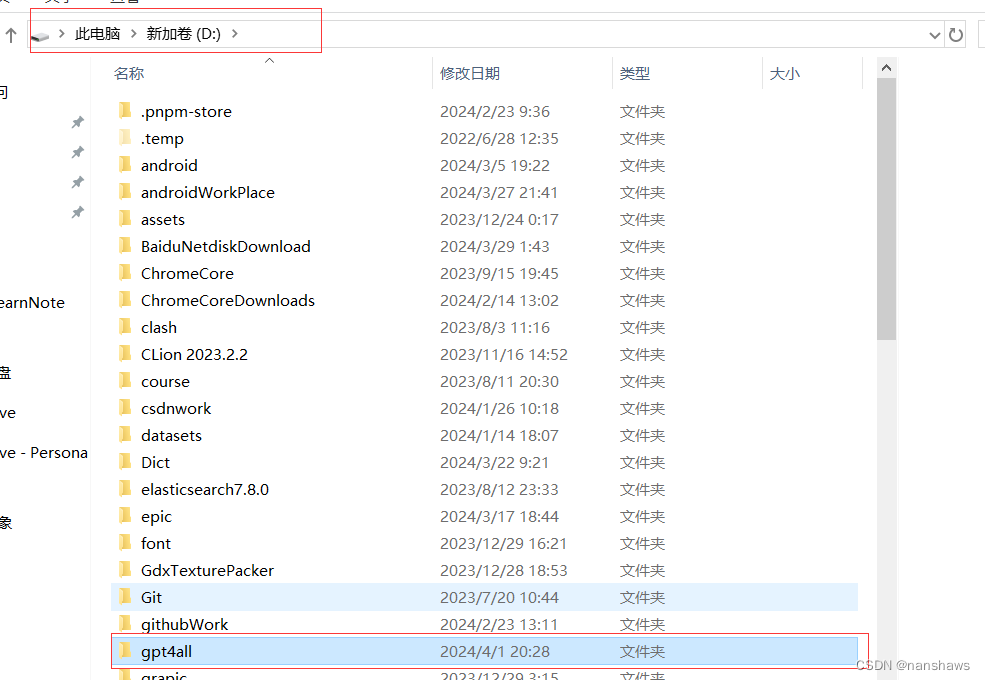

用户可以从GitHub下载GPT4ALL的安装程序包或源代码。对于Windows和MacOS用户,直接运行安装程序即可完成安装。Linux用户则需要先编译安装依赖,然后运行安装脚本。

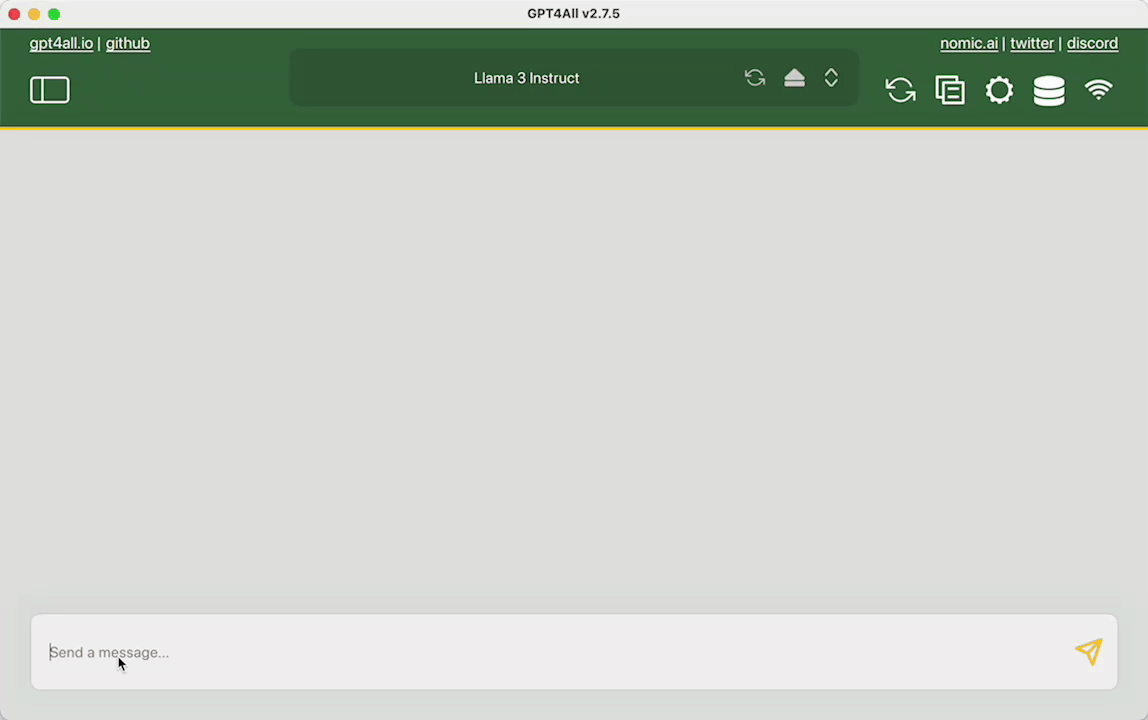

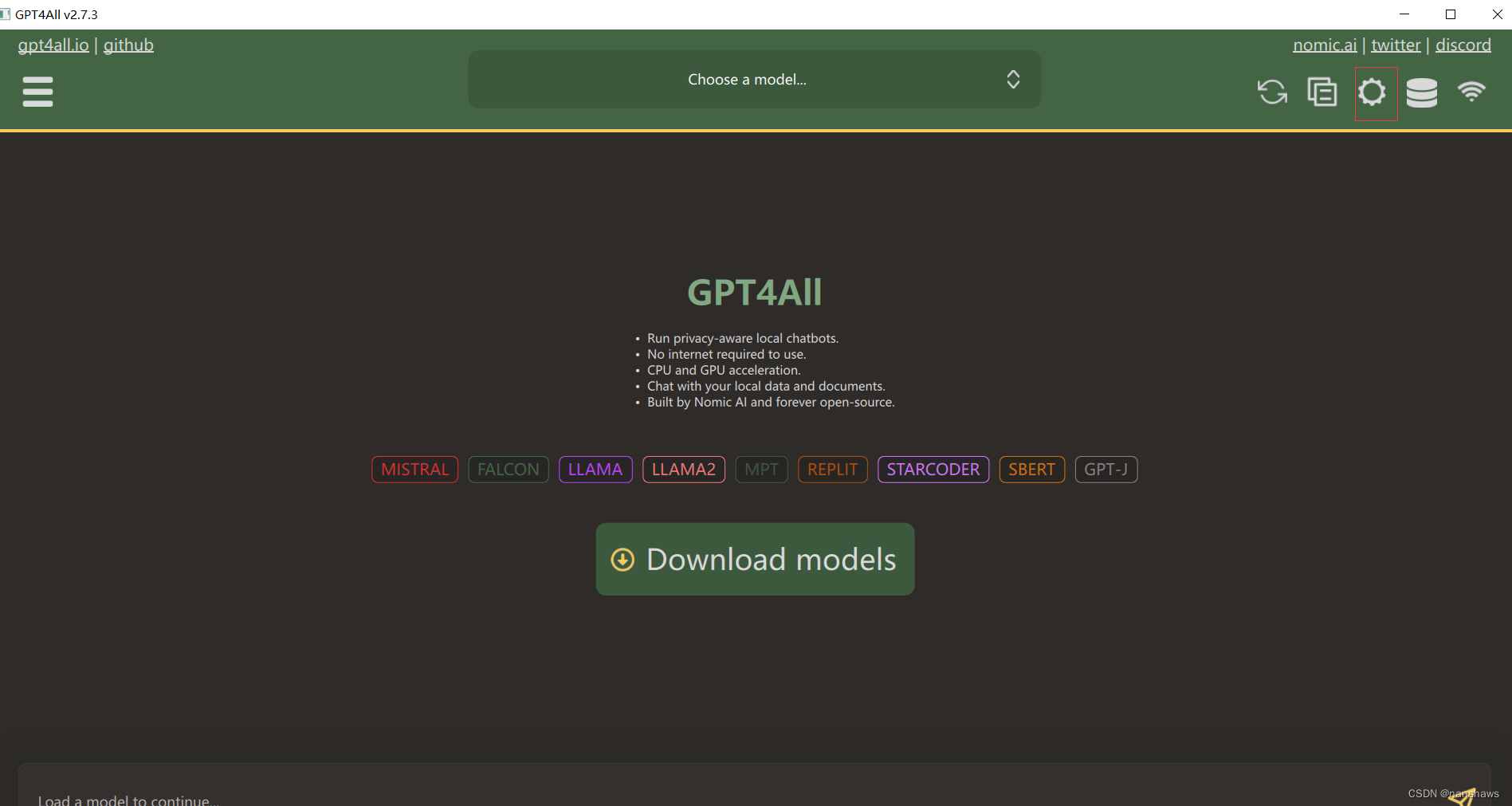

安装完成后,用户可以运行Chat客户端软件,并选择加载的预训练模型。GPT4ALL支持与模型进行文字对话交流,LocalDocs索引文件后可以针对文件内容提问,服务模式下还提供HTTP API供其他应用调用。

GPT4ALL可以应用于多种场景,包括个人对话助手、团队内知识库、网站客服智能对话以及教育培训辅助系统。以下是一些具体的案例:

基于GPT4ALL框架,用户可以实现LLaMA-3模型的部署和推理。通过加载训练后的LLaMA-3的gguf模型文件,用户可以在GUI界面中实现对话聊天。

GPT4ALL可以作为个人对话助手,解答日常问题,提供聊天陪伴。

在团队协作中,GPT4ALL可以作为知识库,用于文档索引和搜索,提高工作效率。

GPT4ALL可以集成到网站中,提供智能客服对话,处理用户咨询。

在教育领域,GPT4ALL可以作为辅助系统,提供学习问答支持,辅助学生学习。

GPT4ALL作为一个开源的LLM生态系统,为用户提供了强大的本地部署和运行大型语言模型的能力。通过详细的设置和使用方法介绍,用户可以轻松地在个人计算机上部署和使用GPT4ALL,享受其带来的便利和高效。随着技术的不断进步,GPT4ALL的应用场景将会更加广泛,为用户提供更多的价值。