Node.js 后端开发指南:搭建、优化与部署

Google的Gemini人工智能大模型以其卓越的性能和广泛的应用范围,成为了AI领域的一颗新星。本文将深入探讨Gemini的特性、能力对比、开发应用以及开源模型Gemma的特点和应用场景。

Gemini是Google发布的人工智能大模型,能够在不同平台上运行,包括数据中心和移动设备。该模型包含三种不同规模的版本:功能强大的Gemini Ultra、中端型号Gemini Pro和适用于特定任务和移动设备的Gemini Nano。Gemini Ultra在大规模多任务语言理解(MMLU)领域超越了人类专家,成为首个达到此成就的模型。

官网链接:Gemini官网

Gemini在多个图像理解基准测试中展现了其强大的能力,如MMLU、VQAv2、文本VQA等。以下是Gemini与GPT-4V在几个关键图像能力基准上的对比:

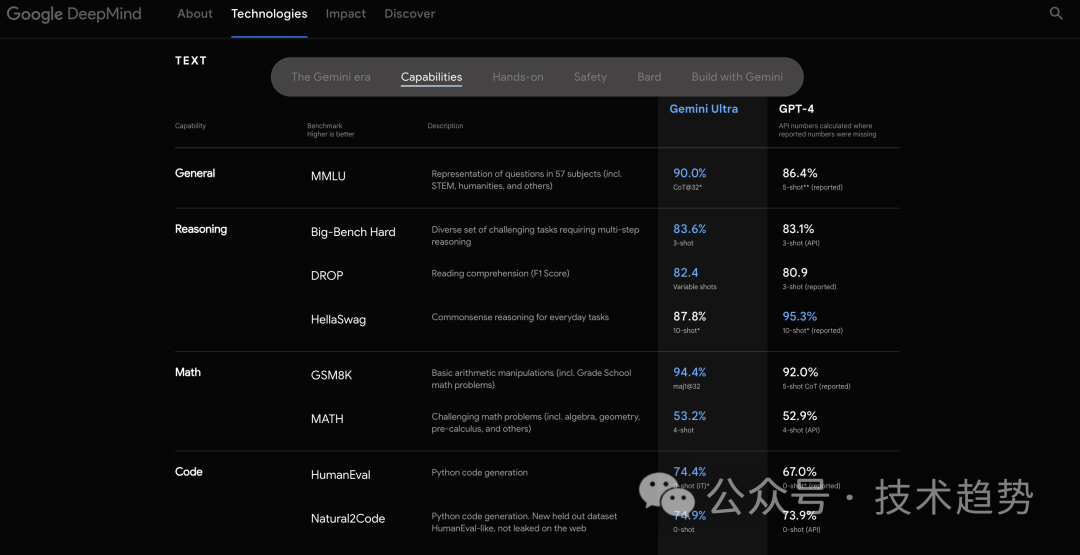

Gemini Ultra在文本能力方面同样表现出色,无论是在MMLU总体学科、推理、数学还是代码生成方面,都超过了GPT-4。

开发者可以通过以下链接申请Google AI的Key,以便开始开发和测试:申请Key。

开发者可以使用Postman等工具调用Gemini的API接口。以下是一个调用示例:

{

“contents”: [

{

“parts”: [

{

“text”: “中国有多少人,历史达几万年,为什么只被算到5000年?,详细介绍一下!”

}

]

}

]

}Google最近开源了名为Gemma的新模型系列,这是对开源AI模型领域的一大补充。Gemma模型基于与Gemini相同的技术构建,但完全公开并允许商用授权。

架构细节:Gemma模型具有不同的参数规模,Gemma-2B有18层,d_model为2048,而Gemma-7B有28层,d_model为3072。

新技术:Gemma采用了新技术如Multi-Query Attention、RoPE Embeddings等,提高了模型的性能。

评测结果:Gemma在70亿参数规模的语言模型中表现最佳,甚至超过了一些参数量更大的模型。

Gemma模型遵循一个自定义的开源协议,允许商业使用,为AI开发者提供了更多的灵活性和可能性。

答:Gemini是Google发布的多模态人工智能大模型,而Gemma是基于相同技术开发的开源大型语言模型,专注于文本处理。

答:开发者可以通过Google AI平台申请Key,并使用提供的API接口开始开发和测试。

答:Gemma模型在多项测试中表现优秀,超过了许多参数更大的模型,特别是在70亿参数规模的语言模型中表现最佳。

答:是的,Gemma模型遵循一个自定义的开源协议,允许商业使用。

答:开源Gemma模型是Google推动AI领域发展和合作的一部分,旨在为开发者提供更多的工具和资源,促进AI技术的创新和应用。