探索Kimi私人AI助手:打造智能化的未来

Kimi私人AI助手是一项革命性的技术,它将人工智能(AI)的强大功能与个人化服务相结合,为用户提供丰富的交互体验。本文将深入探讨Kimi API的使用方法、优势劣势、实际应用场景以及如何通过它来创建个性化的AI助手。

SWOT分析Kimi API

在选择使用任何技术之前,进行SWOT分析是一个重要的步骤。Kimi API作为一个强大的AI工具,其优势和劣势都需要认真评估。

优势(Strengths)

Kimi API的主要优势在于其专业技术壁垒。未开源的大模型通常由专业团队开发,具备先进的技术和算法,这意味着用户可以直接利用这些技术优势,而无需自己构建复杂的模型。此外,Kimi API的易于集成特性使得开发者能够通过几行代码快速接入大模型的能力,从而实现高质量输出。API提供者负责模型的持续更新和维护,这也意味着用户无需担心技术过时问题。

劣势(Weaknesses)

然而,Kimi API也存在一些劣势。由于未开源,用户无法深入了解模型的内部工作原理,定制化能力受限。此外,随着使用量的增加,API调用的费用可能会变得昂贵。数据隐私问题也是用户需要考虑的重要因素,因为将数据发送到外部API可能会引发安全性的问题。

机会(Opportunities)

Kimi API为用户提供了创新应用的机会。开发者可以在自己的产品或服务中快速集成先进的AI功能,推动创新。同时,Kimi API可以应用于多个行业,如医疗、金融、教育等,为企业和开发者提供了满足市场需求的解决方案。

威胁(Threats)

市场上可能存在提供类似服务的竞争者,这可能导致价格战或服务同质化。此外,AI技术的快速变革也可能使现有API迅速过时。法规风险和API服务的中断或质量问题可能影响用户的业务连续性。

Kimi API官方介绍

Kimi API由Moonshot AI开发,提供了强大的语言模型推理服务。它主要通过一个Chat Completions接口来生成文本。这个接口允许用户通过简单的调用生成高质量的文本内容。

Kimi 模型列表

Kimi API提供了多个模型以满足不同的需求:

- moonshot-v1-8k: 适用于生成短文本。

- moonshot-v1-32k: 适用于生成长文本。

- moonshot-v1-128k: 适用于生成超长文本。

这些模型的区别在于它们的最大上下文长度,包括了输入消息和生成的输出。

Kimi API使用方法

使用Kimi API需要提供一个API密钥和一个模型名称。用户可以通过Kimi控制台申请API密钥,并根据需求选择合适的模型来调用API。

Kimi API的限速策略

Kimi API实施了一些限速策略以确保服务稳定性:

- 并发限制: 同一时间内最多处理一个请求。

- RPM(请求每分钟): 每分钟最多3次请求。

- TPM(令牌每分钟): 每分钟最多32000个令牌。

- TPD(令牌每天): 每天最多1.5M个令牌。

实操演示:Python代码实现

在实际应用中,使用Kimi API进行文本生成是一个常见的操作。下面是一个Python的代码示例,展示了如何调用Kimi API进行文本对答。

安装OpenAI库

pip install openai

pip install --upgrade 'openai>=1.0'

pip show openai文本对答

通过以下代码可以实现基本的文本对答功能:

from openai import OpenAI

client = OpenAI(

api_key="api_key",

base_url="https://api.moonshot.cn/v1",

)

#%%

def create_ask_gpt(prompt, session_id=None):

response = client.chat.completions.create(

model="moonshot-v1-8k",

messages=[

{

"role": "system",

"content": "你是 Kimi,由 Moonshot AI 提供的人工智能助手,你更擅长中文和英文的对话。你会为用户提供安全,有帮助,准确的回答。同时,你会拒绝一切涉及恐怖主义,种族歧视,黄色暴力等问题的回答。Moonshot AI 为专有名词,不可翻译成其他语言。",

},

{"role": "user", "content": prompt},

],

temperature=0.3,

stream=True,

)

answer = response.choices[0].message.content

return answer

#%%

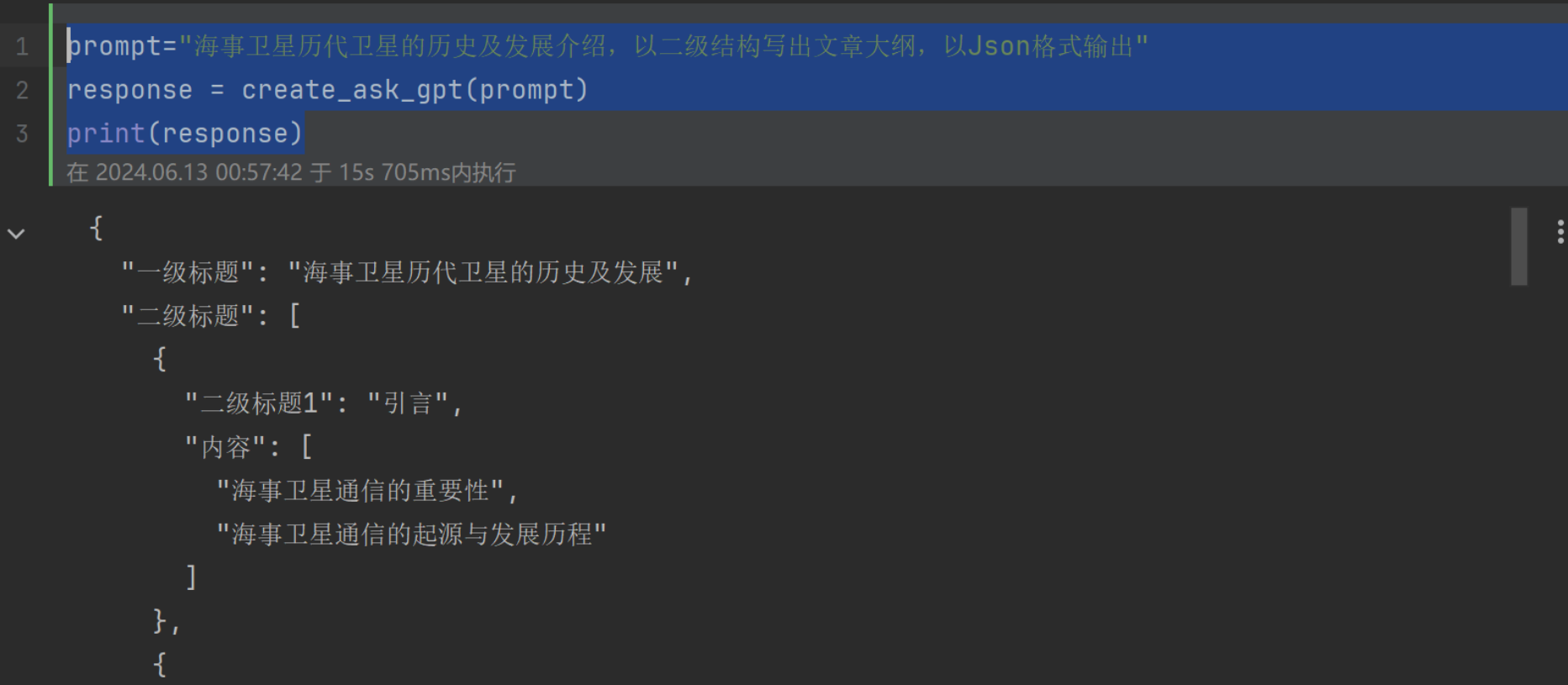

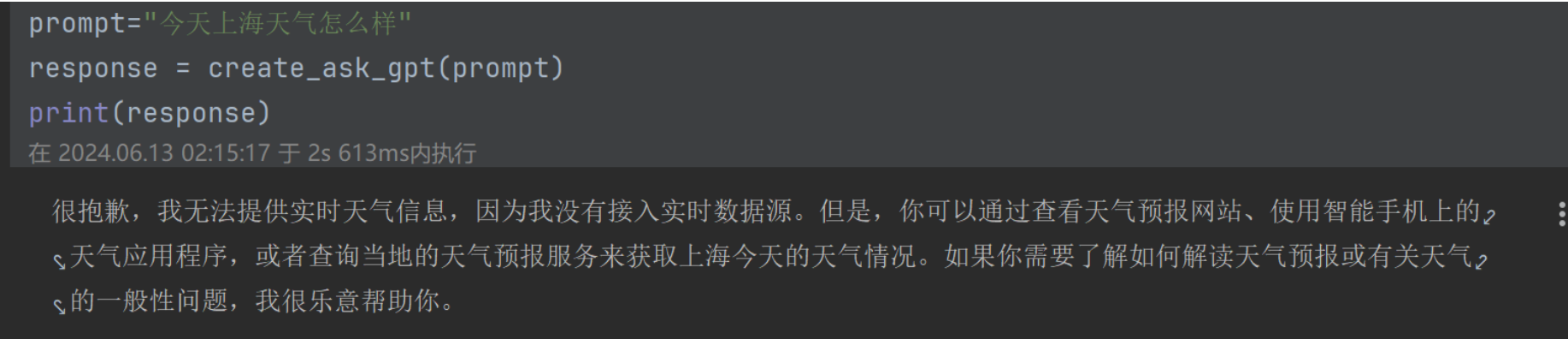

prompt="海事卫星历代卫星的历史及发展介绍,以二级结构写出文章大纲,以Json格式输出"

response = create_ask_gpt(prompt)

print(response)连续对话

为了实现连续对话,可以使用以下循环代码:

while True:

prompt = input("你: ")

response = create_ask_gpt(prompt)

print("Kimi:", response)图片解析

Kimi API还可以用于图片解析,例如解决数学题目。下面是一个示例代码:

from pathlib import Path

from openai import OpenAI

client = OpenAI(

api_key="api_key",

base_url="https://api.moonshot.cn/v1",

)

#%%

file_object = client.files.create(file=Path("testcal.jpg"), purpose="file-extract")

#%%

file_content = client.files.content(file_id=file_object.id).text

#%%

messages = [

{

"role": "system",

"content": "你是 Kimi,由 Moonshot AI 提供的人工智能助手,你更擅长中文和英文的对话。你会为用户提供安全,有帮助,准确的回答。同时,你会拒绝一切涉及恐怖主义,种族歧视,黄色暴力等问题的回答。Moonshot AI 为专有名词,不可翻译成其他语言。",

},

{

"role": "system",

"content": file_content,

},

{"role": "user", "content": "理解图片内容,正确识别题目的数量并对进行判断,确认提供的答案是否正确。"},

]

#%%

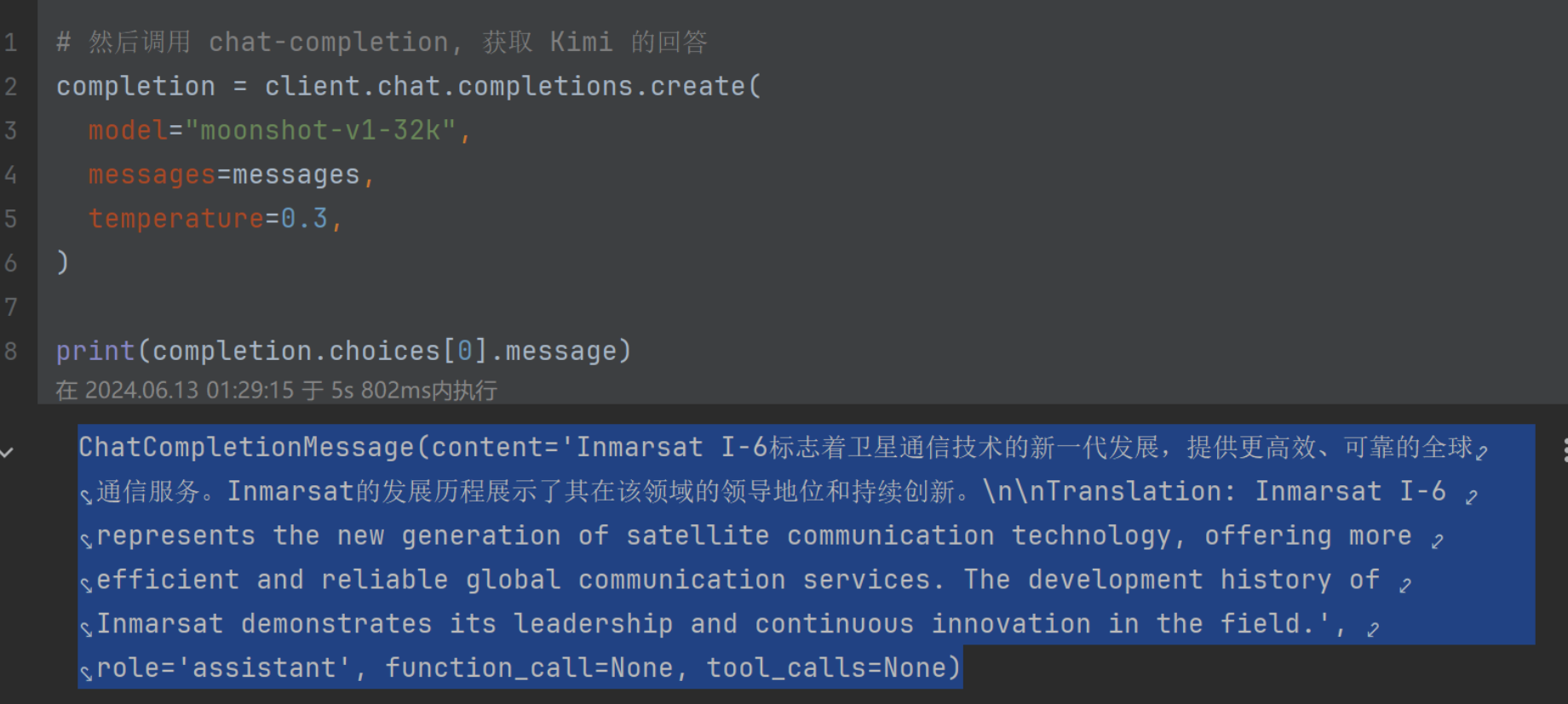

completion = client.chat.completions.create(

model="moonshot-v1-32k",

messages=messages,

temperature=0.3,

)

print(completion.choices[0].message.content)结语

通过Kimi API,用户可以轻松创建出个性化的AI助手,实现从文本对话到图片解析的多种功能。虽然Kimi API有其局限性,但其强大的功能和易用性使得它在AI应用开发中具有巨大的潜力。

FAQ

-

问:Kimi API如何保证数据的安全性?

- 答:Kimi API采用加密传输协议,确保数据在传输过程中的安全性。同时,用户需遵循相关的数据隐私政策。

-

问:如何选择合适的Kimi模型?

- 答:选择模型时需根据文本长度进行选择,短文本适合使用moonshot-v1-8k,长文本则可选择moonshot-v1-32k或moonshot-v1-128k。

-

问:Kimi API支持哪些编程语言?

- 答:Kimi API主要通过HTTP协议进行调用,因此支持任何可以发送HTTP请求的编程语言,包括Python、JavaScript等。

-

问:是否可以自定义Kimi助手的回答风格?

- 答:目前,Kimi API提供了一些参数供用户调整生成文本的风格,但对于深度的自定义,可能需要额外的开发工作。

-

问:Kimi API是否支持多轮对话?

- 答:是的,Kimi API支持多轮对话,用户可以通过在每次请求中传递上下文信息来实现连续对话。