3大AI语言大模型API基础参数、核心性能的区别:ChatGPT 4o、百度千帆 ERNIE 4.0、阿里通义千问 Max

作者:zhilong · 2025-05-28 · 阅读时间:7分钟

在本次深度评测中,我们聚焦ERNIE 4.0、GPT-4o和通义千问Max三大模型的综合表现。采用结构化分析方法,从服务商核心优势、基础技术参数到实际性能测试三个维度展开对比。28个精选指标的客观呈现,将有效辅助您进行技术选型和采购决策。所有数据均来自官方渠道,确保评测结果的权威性和可靠性。

百度千帆 ### 1.服务商优势 • 网站流量市场表现:UV达71.7M,PV达728.2M。 • 中国市场份额:占流量总份额的80.33%。 • SEMrush评分表现:网站评分高达95分,排名第534。 ## OpenAI

### 1.服务商优势 • 网站流量市场表现:UV达71.7M,PV达728.2M。 • 中国市场份额:占流量总份额的80.33%。 • SEMrush评分表现:网站评分高达95分,排名第534。 ## OpenAI ### 1.服务商优势 • 全天候客户服务支持:提供24小时在线服务。 • 优秀的市场表现:网站流量为462.0M,全球排名第112。 ## 通义千问

### 1.服务商优势 • 全天候客户服务支持:提供24小时在线服务。 • 优秀的市场表现:网站流量为462.0M,全球排名第112。 ## 通义千问 ### 1.服务商优势 • 广泛的市场影响力:中国用户占比达88.4%。 • 高流量表现:月均PV达9300万,UV达1260万。

### 1.服务商优势 • 广泛的市场影响力:中国用户占比达88.4%。 • 高流量表现:月均PV达9300万,UV达1260万。

以上仅列举了这几家服务商的部分优势数据。若想获取更多关于网站流量、排名及权重的完整详细信息。请点此查看报表详情👇

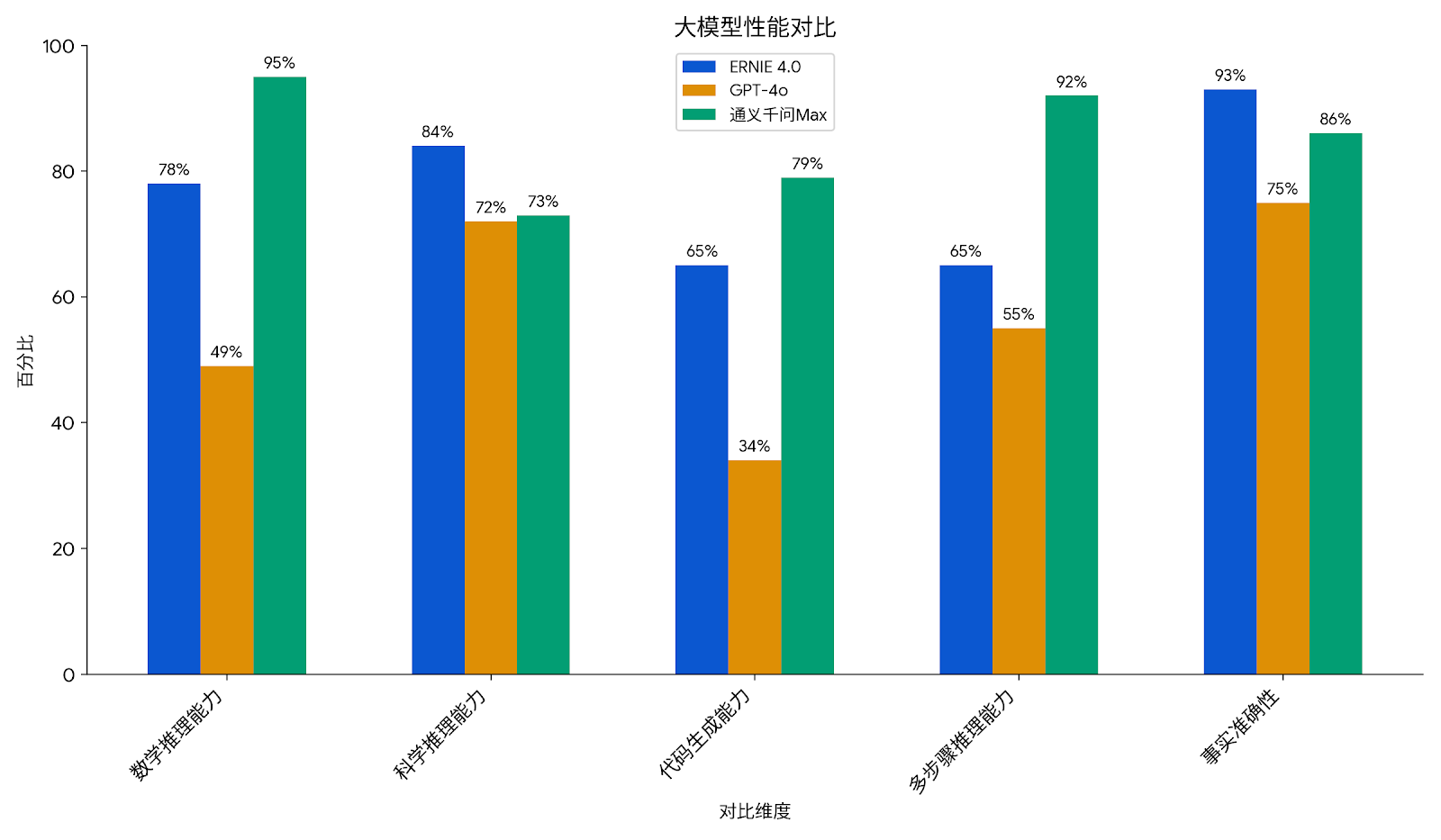

ERNIE 4.0ERNIE 4.0 是一款具有强大自然语言处理能力的大型语言模型。它采用多任务学习框架,能够同时处理多种自然语言处理任务,如文本分类、情感分析、问答系统等。此外,ERNIE 4.0 还通过引入知识图谱,增强了模型对知识的理解能力,提高了在特定领域的性能。它还支持多种语言,具有较好的跨语言能力,可以处理不同语言的自然语言处理任务。 ### gpt-4oGPT-4o 是 OpenAI 开发的多模态大型语言模型,于 2024 年 5 月发布。它采用 Transformer 架构,支持文本、图像和音频输入输出。该模型具备强大的多模态融合能力,能处理多种任务,如图像生成、语音识别和文本生成。GPT-4o 的图像生成功能可生成逼真图像,支持多种风格转换。 ### 通义千问 Max通义千问-Max,即Qwen2.5-Max,是阿里云通义千问旗舰版模型,于2025年1月29日正式发布。该模型预训练数据超过20万亿tokens,在多项公开主流模型评测基准上录得高分,位列全球第七名,是非推理类的中国大模型冠军。它展现出极强劲的综合性能,特别是在数学和编程等单项能力上排名第一。 >了解完各大厂商的市场表现后,是时候深入技术细节了。在接下来的章节中,我们将对ERNIE 4.0、GPT-4o和通义千问Max进行专业级的参数对比和性能测评, 包括 > – 基础架构规格横向对比 > – 实际运行效能测试数据 > > 帮助您从技术层面把握各模型的真实实力 ## AI大模型多维度对比分析 ### 1.基础参数对比 | API模型名称 | 输入方式 | 输出方式 | 上下文长度(Token) | 上下文理解 | 文档理解 | 是否支持流式输出 | 是否支持联网搜索 | 是否开源 | 多模态支持 | |:———–|:———:|:———:|:—————–:|:———-:|:——–:|:—————–:|:—————-:|:——–:|:———–:| | 百度千帆 | 文本 | 文本 | 5K | ✅ | ✅ | ✅ | ✅ | ❌ | ❌ | | OpenAI | 文本、图片 | 文本 | 12.8k | ✅ | ✅ | ✅ | ✅ | ❌ | ✅ | | 通义千问 | 文本/图片/视频链接 | 文本 | 32k | ✅ | ⚪ | ✅ | ✅ | ❌ | ✅ | 百度千帆具备较好的上下文和文档理解能力,支持流式输出和联网搜索,适合实时信息处理;OpenAI以支持多模态输入和最长的上下文长度为优势,适用于复杂多样的任务需求;通义千问在多模态支持和较长的上下文长度上表现突出,适合多媒体内容的综合分析。整体来看,各模型在输入多样性和上下文处理能力上各有优势,选择时应根据具体应用场景的需求进行权衡。 ### 2.性能基准测试对比  #### 数学推理能力 (GSM8K/MATH基准) – ERNIE 4.0 在中文数学推理任务中表现优异,C-Eval测试中数学子项得分77.78分。其知识增强架构特别适合符号计算和公式推导,但处理超长数学证明时受限于5K上下文窗口。 – GPT-4o 数学综合能力略优于ERNIE 4.0,AIME竞赛测试得分49%。多模态输入能力可辅助几何问题求解,但中文数学术语理解稍弱。 – 通义千问Max LiveCodeBench数学测试超越DeepSeek-R1,支持1000万token超长上下文处理复杂数学问题。Qwen2.5-Max版本在动态数学模拟任务中表现突出。 #### 科学推理能力 (MMLU/AGI Eval科学子集) – ERNIE 4.0 MMLU科学类测试得分83.54分,生物学和地球科学领域优势明显。集成百度搜索插件确保科学事实时效性。 – GPT-4o 多模态科学理解能力强,GPQA博士级测试得分72%。视觉数据辅助实验设计分析,但专业领域深度弱于ERNIE。 – 通义千问Max AGI Eval科学推理得分72.62分,物理和化学领域表现均衡。Qwen-VL多模态模型可解析科学图表。 #### 代码生成能力 (AGI Eval编程子集) – ERNIE 4.0 代码生成稳定性强,HumanEval测试通过率65.48%。支持128K上下文适合全栈开发,但复杂算法实现能力有限。 – GPT-4o 代码补全流畅度最佳,但LiveCodeBench硬核测试仅34分。多语言注释生成能力强,适合国际化团队协作。 – 通义千问Max LiveCodeBench得分79.4%,QwQ推理模型在AIME编程测试中达DeepSeek-R1满血版水平。支持百万级token上下文处理大型项目。 #### 多步骤推理能力 (AGI Eval/OctoTools测试) – ERNIE 4.0 逻辑推理得分65.48分,适合5步内的结构化推理。跨模态关联能力增强医疗诊断等场景的步骤连贯性。 – GPT-4o 斯坦福OctoTools测试显示多步推理准确率被开源框架反超9.3%。"思维链搜索"功能可回溯推理过程。 – 通义千问Max Arena-Hard测试得分1332分,非推理类中国模型第一。Qwen-Plus模型支持38K思维链长度,优化长程依赖处理。 #### 事实准确性 (C-Eval/MMLU事实核查) – ERNIE 4.0 中文事实核查全球领先,C-Eval测试11项全优。安全与价值观评分92.86分,企业级数据验证流程严格。 – GPT-4o 多模态数据增强事实验证,但中文语境处理弱于ERNIE。时效性数据更新存在1-3个月延迟。 – 通义千问Max FlagEval测试中知识运用得分85.44分。金融云版本通过区块链技术保障数据溯源准确性。 — > – 中文场景首选:ERNIE 4.0(安全合规)> 通义千问Max(技术硬核)> GPT-4o(多模态) > – 技术开发者推荐:通义千问Max(代码/数学)> GPT-4o(协作生态)> ERNIE 4.0(企业集成) > – 最大差距领域:代码生成(通义千问Max领先GPT-4o 133%) > – 最小差距领域:中文事实核查(ERNIE 4.0仅领先通义千问Max 7.4%) ## 总结 上面重点对比了ERNIE 4.0、gpt-4o、通义千问 Max的服务商优势,基础参数,性能基准测试对比,若要查看其他2025国内AI大模型对比情况包括百度千帆,OpenAI,通义千问等主流供应商。请点此查看完整报告或可以自己选择期望的服务商制作比较报告

#### 数学推理能力 (GSM8K/MATH基准) – ERNIE 4.0 在中文数学推理任务中表现优异,C-Eval测试中数学子项得分77.78分。其知识增强架构特别适合符号计算和公式推导,但处理超长数学证明时受限于5K上下文窗口。 – GPT-4o 数学综合能力略优于ERNIE 4.0,AIME竞赛测试得分49%。多模态输入能力可辅助几何问题求解,但中文数学术语理解稍弱。 – 通义千问Max LiveCodeBench数学测试超越DeepSeek-R1,支持1000万token超长上下文处理复杂数学问题。Qwen2.5-Max版本在动态数学模拟任务中表现突出。 #### 科学推理能力 (MMLU/AGI Eval科学子集) – ERNIE 4.0 MMLU科学类测试得分83.54分,生物学和地球科学领域优势明显。集成百度搜索插件确保科学事实时效性。 – GPT-4o 多模态科学理解能力强,GPQA博士级测试得分72%。视觉数据辅助实验设计分析,但专业领域深度弱于ERNIE。 – 通义千问Max AGI Eval科学推理得分72.62分,物理和化学领域表现均衡。Qwen-VL多模态模型可解析科学图表。 #### 代码生成能力 (AGI Eval编程子集) – ERNIE 4.0 代码生成稳定性强,HumanEval测试通过率65.48%。支持128K上下文适合全栈开发,但复杂算法实现能力有限。 – GPT-4o 代码补全流畅度最佳,但LiveCodeBench硬核测试仅34分。多语言注释生成能力强,适合国际化团队协作。 – 通义千问Max LiveCodeBench得分79.4%,QwQ推理模型在AIME编程测试中达DeepSeek-R1满血版水平。支持百万级token上下文处理大型项目。 #### 多步骤推理能力 (AGI Eval/OctoTools测试) – ERNIE 4.0 逻辑推理得分65.48分,适合5步内的结构化推理。跨模态关联能力增强医疗诊断等场景的步骤连贯性。 – GPT-4o 斯坦福OctoTools测试显示多步推理准确率被开源框架反超9.3%。"思维链搜索"功能可回溯推理过程。 – 通义千问Max Arena-Hard测试得分1332分,非推理类中国模型第一。Qwen-Plus模型支持38K思维链长度,优化长程依赖处理。 #### 事实准确性 (C-Eval/MMLU事实核查) – ERNIE 4.0 中文事实核查全球领先,C-Eval测试11项全优。安全与价值观评分92.86分,企业级数据验证流程严格。 – GPT-4o 多模态数据增强事实验证,但中文语境处理弱于ERNIE。时效性数据更新存在1-3个月延迟。 – 通义千问Max FlagEval测试中知识运用得分85.44分。金融云版本通过区块链技术保障数据溯源准确性。 — > – 中文场景首选:ERNIE 4.0(安全合规)> 通义千问Max(技术硬核)> GPT-4o(多模态) > – 技术开发者推荐:通义千问Max(代码/数学)> GPT-4o(协作生态)> ERNIE 4.0(企业集成) > – 最大差距领域:代码生成(通义千问Max领先GPT-4o 133%) > – 最小差距领域:中文事实核查(ERNIE 4.0仅领先通义千问Max 7.4%) ## 总结 上面重点对比了ERNIE 4.0、gpt-4o、通义千问 Max的服务商优势,基础参数,性能基准测试对比,若要查看其他2025国内AI大模型对比情况包括百度千帆,OpenAI,通义千问等主流供应商。请点此查看完整报告或可以自己选择期望的服务商制作比较报告

热门推荐

一个账号试用1000+ API

助力AI无缝链接物理世界 · 无需多次注册

3000+提示词助力AI大模型

和专业工程师共享工作效率翻倍的秘密

最新文章

- 用 Poe-API-wrapper 连接 DALLE、ChatGPT,批量完成AI绘图或文字创作

- RESTful Web API 设计中要避免的 6 个常见错误

- LangGraph 工具详解:构建 AI 多步骤流程的关键利器

- GitHubAPI调用频率限制的增加方法

- 如何使用Route Optimization API优化配送路线

- 什么是聚类分析?

- 安全好用的OpenApi

- 医疗数据管理与fhir api的未来发展趋势

- 为什么要使用Google My Business Reviews API

- 2025年7月第2周GitHub热门API推荐:rustfs/rustfs、pocketbase/pocketbase、smallcloudai/refact

- API设计的首要原则

- 左手用R右手Python系列——百度地图API调用与地址解析/逆解析

热门推荐

一个账号试用1000+ API

助力AI无缝链接物理世界 · 无需多次注册