事件流处理服务-Keen

专用API

【更新时间: 2024.09.18】

事件流处理服务是一个强大的平台,允许用户从互联网上的任何连接设备轻松收集事件数据。无论是您的网站、应用程序、后端服务器、智能设备还是第三方系统等,都可以通过使用Keen的强大REST API和多种SDK来收集这些数据。

免费

去服务商官网采购>

|

浏览次数

460

采购人数

0

试用次数

0

SLA: N/A

SLA: N/A

响应: N/A

响应: N/A

适用于个人&企业

适用于个人&企业

收藏

×

完成

取消

×

书签名称

确定

|

- API详情

- 定价

- 使用指南

- 常见 FAQ

- 关于我们

什么是Keen的事件流处理服务?

事件流处理服务-Keen基于 Apache Kafka ® 构建,轻松从任何地方收集事件数据,添加丰富的属性,并发送到您需要的任何地方。是一个专注于事件数据收集、丰富和转换的服务平台。它为用户提供了一种方法来从各种来源收集事件数据,并通过多种方式丰富这些数据,如添加地理位置信息、设备类型等额外维度。同时,它也支持将数据发送到所需的任何地方,从而帮助用户更好地理解和利用他们的数据资产。 |

|

Keen的事件流处理服务有哪些核心功能?

|

从任何来源串流 使用从 JavaScript 到 Go 的超过 15 个 SDK,从堆栈中的任何位置进行 POST。 |

|

|

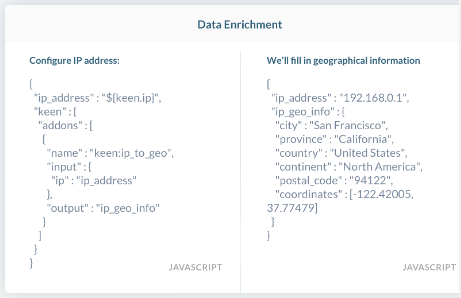

丰富与转变 使用丰富功能添加维度,例如位置、工作日、访问设备等。 |

|

将数据发送到任何需要的地方 使用 Keen 安全存储数据,以便使用 Keen Compute 进行即时查询和构建实时数据产品。 |

|

Keen的事件流处理服务的核心优势是什么?

1.快速部署与数据收集:使用我们全面的工具和 SDK 集快速启动并运行。您可以立即快速收集数据。

2. 全天候支持与专业团队:让Keen的人代替你的人负责寻呼机。我们的全球开发人员和支持人员团队确保平台 365、24/7 持续运行。

3. 完全定制化解决方案:通过完全可定制的堆栈准确构建您所需要的内容。您可以完全控制收集哪些数据以及如何描述数据。

4. 减少运维风险与复杂性:降低您的运营和交付风险。避免维护容错数据管道带来的不可避免的麻烦。

在哪些场景会用到Keen的事件流处理服务?

| 产品分析:企业可以使用该服务来跟踪产品的使用情况和用户的互动情况,从而获得产品性能的真实视图,并据此做出改进决策。 |

|

| 面向客户的度量指标:通过集成“事件流处理服务-Keen”,公司可以快速开发出产品内的分析工具,减少开发时间,同时提供给客户实时的度量信息。 |

|

| 业务运营:销售、市场和财务团队可以通过此服务来整合其使用的各种工具,从而更有效地管理业务操作并做出决策。例如,营销团队可以根据用户的活动数据来优化营销策略,而财务团队则可以根据实际使用情况调整计费模型。 |

|

验证

Keen 支持两种用于验证 HTTP API 请求的机制,一种用于 Kafka API 的验证机制。您想要使用的项目都需要API 密钥。

验证请求的一种方法是使用名为“Authorization”的 HTTP 标头。此方法适用于每个 API 调用。

所有 POST 都需要将“Content-Type”标头设置为“application/json”。

API 密钥

您的每个项目都会有自己的一组 API 密钥,您可以从项目的概述页面检索这些密钥。

1.转到PROJECT_ID

2.单击“访问”选项卡

3.选择并复制适当的密钥

示例

import KeenAnalysis from 'keen-analysis';

const client = new KeenAnalysis({

projectId: 'PROJECT_ID',

readKey: 'READ_KEY',

writeKey: 'WRITE_KEY'

});

开始使用

Keen 现在提供使用Apache Kafka作为流式传输和备份事件的接口之一的流式传输,从而轻松与外部系统集成。

事件生产

使用具有写密钥(Write Key)认证的 Kafka 生产者可以将事件流传输到一个主题(Topic)。不需要提前创建主题,因为 auto.create.topics.enable=true。主题名称在项目中必须是唯一的,且该名称用于表示所传输事件的集合名称。传输到 Keen Kafka Inbound 集群的事件与通过 HTTP API 传输的事件处理方式相同。

事件消费

你可以使用具有读密钥(Read Key)认证的 Kafka 消费者来消费事件流。同样不需要提前创建主题,因为 auto.create.topics.enable=true。要从特定的事件集合进行消费,使用该集合名称作为 Kafka 消费者的主题名称(如果你也使用 Kafka 进行事件流传输,这将与 Kafka 生产者使用的主题名称相同)。通过 HTTP API 和 Kafka 生产者发送的事件都将传输到 Outbound Kafka 集群。你可以通过 HTTP API 发送一些事件,通过 Kafka 生产者发送另一些事件,然后使用 Kafka 消费者消费所有事件。所有可在 Outbound Kafka 集群中消费的事件都会按照数据丰富(Data Enrichment)描述进行丰富。

详情参考:https://keen.io/docs/api/#kafka-event-streaming

验证

Keen 支持两种用于验证 HTTP API 请求的机制,一种用于 Kafka API 的验证机制。您想要使用的项目都需要API 密钥。

验证请求的一种方法是使用名为“Authorization”的 HTTP 标头。此方法适用于每个 API 调用。

所有 POST 都需要将“Content-Type”标头设置为“application/json”。

API 密钥

您的每个项目都会有自己的一组 API 密钥,您可以从项目的概述页面检索这些密钥。

1.转到PROJECT_ID

2.单击“访问”选项卡

3.选择并复制适当的密钥

示例

import KeenAnalysis from 'keen-analysis';

const client = new KeenAnalysis({

projectId: 'PROJECT_ID',

readKey: 'READ_KEY',

writeKey: 'WRITE_KEY'

});

开始使用

Keen 现在提供使用Apache Kafka作为流式传输和备份事件的接口之一的流式传输,从而轻松与外部系统集成。

事件生产

使用具有写密钥(Write Key)认证的 Kafka 生产者可以将事件流传输到一个主题(Topic)。不需要提前创建主题,因为 auto.create.topics.enable=true。主题名称在项目中必须是唯一的,且该名称用于表示所传输事件的集合名称。传输到 Keen Kafka Inbound 集群的事件与通过 HTTP API 传输的事件处理方式相同。

事件消费

你可以使用具有读密钥(Read Key)认证的 Kafka 消费者来消费事件流。同样不需要提前创建主题,因为 auto.create.topics.enable=true。要从特定的事件集合进行消费,使用该集合名称作为 Kafka 消费者的主题名称(如果你也使用 Kafka 进行事件流传输,这将与 Kafka 生产者使用的主题名称相同)。通过 HTTP API 和 Kafka 生产者发送的事件都将传输到 Outbound Kafka 集群。你可以通过 HTTP API 发送一些事件,通过 Kafka 生产者发送另一些事件,然后使用 Kafka 消费者消费所有事件。所有可在 Outbound Kafka 集群中消费的事件都会按照数据丰富(Data Enrichment)描述进行丰富。

详情参考:https://keen.io/docs/api/#kafka-event-streaming